Установка Node.JS на Linux-сервере | firstvds.ru

Node.JS — это среда исполнения JavaScript-кода. Она основана на движке V8, использующемся в браузере Google Chrome. С помощью Node.JS на JavaScript можно писать серверные приложения или бэкенд для сайтов.

Установка Node.JS на сервер может понадобиться по разным причинам. От них зависит выбор способа установки:

Для установки подключитесь к серверу по SSH.

Узнать последнюю актуальную версию Node.JS можно на официальном сайте:

Установка Node.JS из репозиториев операционной системы

При установке из стандартного репозитория вы получите неактуальную версию — ту, которая была доступна на момент выпуска вашей операционной системы. Для разработки или подготовки сервера под боевой проект этот способ установки не подойдёт. Но для обучения или экспериментов с кодом использовать можно.

Чтобы проверить доступную для установки версию, используйте команду:

Ubuntu и Debian:

apt show nodejs

Centos:

yum info nodejs

Установка выполняется за один шаг:

Чтобы убедиться, что установка прошла корректно, проверьте версию Node. JS и пакетного менеджера

JS и пакетного менеджера npm:

Ubuntu и Debian:

nodejs -v npm -v

Centos:

node -v npm -v

Установка Node.JS из репозиториев NodeSource

При этом способе установки можно установить актуальную версию Node.JS. Список поддерживаемых операционных систем можно увидеть здесь.

Для установки потребуется curl. Во многих современных дистрибутивах Linux-систем он установлен по умолчанию. При необходимости можно выполнить ручную установку:

Ubuntu и Debian:

apt install -y curl

Centos:

yum install -y curl

Для примера выполним установку последней стабильной версии Node.JS. Для этого нужно выполнить команды:

Чтобы убедиться, что установка прошла корректно, проверим версию Node.JS и пакетного менеджера npm:

Ubuntu и Debian:

nodejs -v npm -v

Centos:

node -v npm -v

Установка Node.

JS с помощью менеджера версий nvm

JS с помощью менеджера версий nvmNode Version Manager, или nvm, позволяет устанавливать любые версии Node.JS и при необходимости переключаться между ними. Инструкция по установке последней версии nvm доступна в описании официального Github-репозитория.

Для примера установим текущую актуальную версию nvm. Для этого, как в предыдущем случае, нам понадобится curl. С его помощью мы скачаем и запустим скрипт установки:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.36.0/install.sh | bash

Скрипт установит nvm

root и его папка /root) и добавит алиас для вызова менеджера в конфигурационный файл пользователя. Чтобы обновить терминал с учётом этих изменений, введите команду:source ~/.bashrc

После этого проверим версию nvm, чтобы убедиться, что установка выполнена корректно:

nvm -v

Теперь мы можем использовать весь функционал nvm.

Просмотреть полный список доступных к установке версий Node.JS можно с помощью команды:

nvm ls-remote

Установить самую последнюю версию Node.JS можно следующим образом:

nvm install node

node в примере — это алиас к последней актуальной версии.

Установить конкретную версию из списка доступных можно так:

nvm install v12.19.0

где v12.19.0 — номер необходимой версии Node.JS, который можно скопировать в выводе команды nvm ls-remote.

После установки проверьте, что Node.JS установлен корректно, с помощью команды:

node -v

Для проверки списка уже установленных версий Node.JS введите в терминале:

nvm ls

Между установленными версиями можно переключаться. Например, в примере с помощью v12.19.0. Помимо неё мы можем переключиться на ранее установленную системную версию (которую можно установить одним из предыдущих способов установки Node. JS) или любую другую:

JS) или любую другую:

nvm use system

Удалить установленную с помощью nvm версию Node.JS можно в два шага:

Проверяем, какая версия Node.JS сейчас используется:

nvm current

Если используется та версия, которую нужно удалить, сначала необходимо деактивировать её, после чего уже выполнить удаление:

Если используется другая версия, удаление можно запустить сразу:

nvm uninstall v12.19.0

Express/Node introduction — Изучение веб-разработки

В этой первой статье по Express мы ответим на вопросы «Что такое Node?» и «Что такое Express?», и сделаем обзор того, что делает веб-фреймворк Express таким особенным. Мы расскажем об основных функциях и покажем вам некоторые из основных строительных блоков приложения Express (хотя на данный момент у вас еще нет среды разработки, в которой можно ее протестировать).

Node (или более формально Node. js

js

С точки зрения веб-серверной разработки Node имеет ряд преимуществ:

- Отличная производительность! Node был разработан для оптимизации пропускной способности и масштабируемости в веб-приложениях и очень хорошо справляется со многими распространенными проблемами веб-разработки (например, веб-приложения реального времени).

- Код написан на «обычном старом JavaScript», а это означает, что затрачивается меньше времени при написании кода для браузера и веб-сервера связанное с «переключением технологий» между языками.

- JavaScript является относительно новым языком программирования и имеет преимущества от улучшения дизайна языка по сравнению с другими традиционными языками для веб-серверов (например, Python, PHP, и т.д.). Многие другие новые и популярные языки компилируются/конвертируются в JavaScript, поэтому вы можете также использовать CoffeeScript, ClosureScript, Scala, LiveScript, etc.

- Менеджер пакетов Node (NPM) обеспечивает доступ к сотням тысяч многоразовых пакетов. Он также имеет лучшее в своем классе разрешение зависимостей и может также использоваться для автоматизации большинства инструментов построения.

- Он портативен, имеет версии для Microsoft Windows, OS X, Linux, Solaris, FreeBSD, OpenBSD, WebOS, и NonStop OS. Кроме того, он имеет хорошую поддержку среди многих хостинг-провайдеров, которые часто предоставляют конкретную инфраструктуру и документацию для размещения сайтов, работающих на Node.

- Он имеет очень активную стороннюю экосистему и сообщество разработчиков, которые всегда готовы помочь.

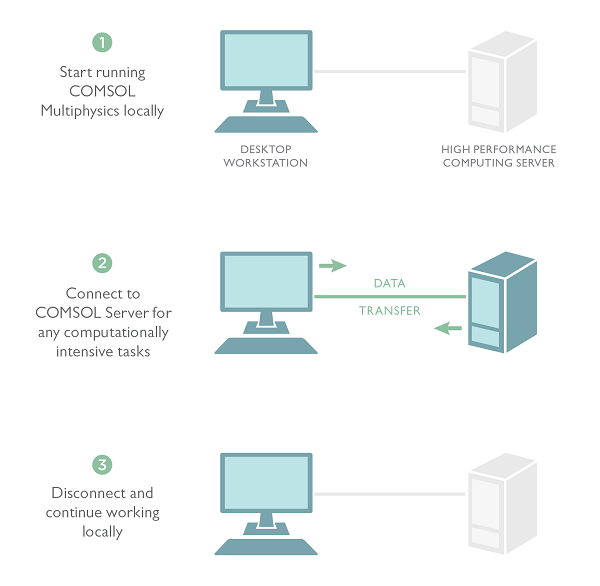

Вы можете изпользовать Node.js для создания простого веб сервера используя пакет Node HTTP.

Hello Node.js

Следующий пример создаёт веб сервер который прослушивает любой HTTP запрос на URL http://127.0.0.1:8000/ — когда запрос будет получен, скрипт ответит строкой «Hello World». Если Вы уже установили node, можете, следуя шагам инструкции попробовать пример:

- Откройте терминал (в Windows окно командной строки)

- Создайте папку, куда вы хотите сохранить программу, к примеру

test-node

cd test-node- Используя любимый текстовый редактор, создайте файл

hello.jsи вставьте в него код:

const http = require("http");

const hostname = "127.0.0.1";

const port = 8000;

const server = http.createServer((req, res) => {

res.writeHead(200, {'Content-Type': 'text/plain'});

res.end('Hello World\n');

});

server. listen(port, hostname, () => {

console.log(`Server running at http://${hostname}:${port}/`);

})

listen(port, hostname, () => {

console.log(`Server running at http://${hostname}:${port}/`);

})

- Сохраните файл в папку, созданную выше.

- Вернитесь в терминал и выполните следующую команду:

node hello.jsВ итоге, перейдите по ссылке http://localhost:8000 в вашем браузере; вы должны увидеть текст «Hello World» в верху слева на чистой странице.

Другие общие для веб-программирования задачи не поддерживаются на прямую Node. Если вы хотите добавить специфичную поддержку различных HTTP методов (например GET, POST, DELETE, и т.д.) по разному для разных URL путей («routes»), отдачу статических файлов, или использовать шаблоны для создания динамических ответов, вам нужно написать код самим, или можете отказаться от изобретения колеса и использовать фреймворк!

Express — самый популярный веб-фреймворк для Node. Он является базовой библиотекой для ряда других популярных веб-фреймворков Node. Он предоставляет следующие механизмы:

Он предоставляет следующие механизмы:

- Написание обработчиков для запросов с различными HTTP-методами в разных URL-адресах (маршрутах).

- Интеграцию с механизмами рендеринга «view», для генерации ответов, вставляя данные в шаблоны.

- Установка общих параметров веб-приложения, такие как порт для подключения, и расположение шаблонов, которые используются для отображения ответа.

- «промежуточное ПО» для дополнительной обработки запроса в любой момент в конвейере обработки запросов.

В то время как сам express довольно минималистичный, разработчики создали совместимые пакеты промежуточного программного обеспечения для решения практически любой проблемы с веб-разработкой. Существуют библиотеки для работы с куки-файлами, сеансами, входами пользователей, параметрами URL, данными POST, заголовками безопасности и многими другими. Вы можете найти список пакетов промежуточного программного обеспечения, поддерживаемых командой Express в Express Middleware (наряду со списком некоторых популярных пакетов сторонних производителей) .

Примечание: Гибкость это палка о двух концах. Существуют пакеты промежуточного программного обеспечения (middleware) для решения практически любых проблем или для удовлетворения любых ваших требований, но правильный выбор подходящих пакетов иногда может быть проблемой. Также нет «правильного пути» для структурирования приложения, и многие примеры, которые вы можете найти в Интернете, не являются оптимальными или лишь показывают небольшую часть того, что вам нужно сделать для разработки веб-приложения.

Node первоначально был выпущен только под Linux в 2009. Менеджер пакетов NPM был выпущен в 2010, а поддержка Windows была добавлена в 2012. Текущая LTS-версия Node v12.16.1 , в то время как последний выпуск Node версии 13.11.0. Это короткий экскурс в историю; обратитесь к Википедии, если вы хотите узнать больше).

Express первоначально был выпущен в ноябре 2010 и текущая версия API 4.17.1 Вы можете отследить изменения и текущий релиз, и GitHub для более детальной информации о релизах.

Популярность веб-фрэймворка важна, поскольку она является индикатором того, будет ли она продолжаться, и какие ресурсы, вероятно, будут доступны с точки зрения документации, дополнительных библиотек и технической поддержки.

Не существует какого-либо доступного и точного измерения популярности серверных фреймворков (хотя сайты, такие как Hot Frameworks, пытаются оценить популярность, используя такие механизмы, как подсчет количества проектов на GitHub и вопросов на StackOverflow для каждой платформы). Лучший вопрос заключается в том, достаточно ли популярны Node и Express, чтобы избежать проблем с непопулярными платформами. Они продолжают развиваться? Можете ли вы получить помощь, если вам это нужно? Есть ли у вас возможность получить оплачиваемую работу, если вы изучаете Express?

Как только мы посмотрим на список широкоизвестных компаний пользующихся Express, количество разработчиков участвующих в разработке Express, и громадному числу людей, которые занимаются поддержкой Express, то мы с уверенностью скажем — Express поистине популярный фреймворк!

Web-фрэймворки часто принято делить на «ограничивающие» и «неограничивающие».

Ограничивающими фрэймворки считаются фрэймворки, которые следуют «должным» ограничениям при выполнении отдельных задач. Довольно часто они ориентированы на ускоренную разработку в конкретной области (решение задач определенного типа), поскольку должный подход к произвольно выбранной задаче бывает не прост для понимания и плохо документирован. При этом они лишаются гибкости при решении задач выходящих за сферу их обычного применения, а так же проявляют тенденцию к ограничению выбора компонентов и подходов своего применения.

Напротив, неограничивающие фреймворки имеют гораздо меньше ограничений для связи компонентов, что бы достичь цели или ограничений в выборе используемых компонентов. Они облегчают разработчикам использование наиболее подходящих инструментов для выполнения конкретной задачи, но платой за это будет то, что вы самостоятельно должны найти такие компоненты.

Express не ограничивающий. Вы можете вставить в цепочку обработки (middleware) запросов практически любое совместимые промежуточные компоненты, которые вам нравятся. Вы можете структурировать приложение в одном файле или в нескольких, использую любую структуру каталогов. Иногда вы можете чувствовать, что у вас слишком много вариантов!

Вы можете структурировать приложение в одном файле или в нескольких, использую любую структуру каталогов. Иногда вы можете чувствовать, что у вас слишком много вариантов!

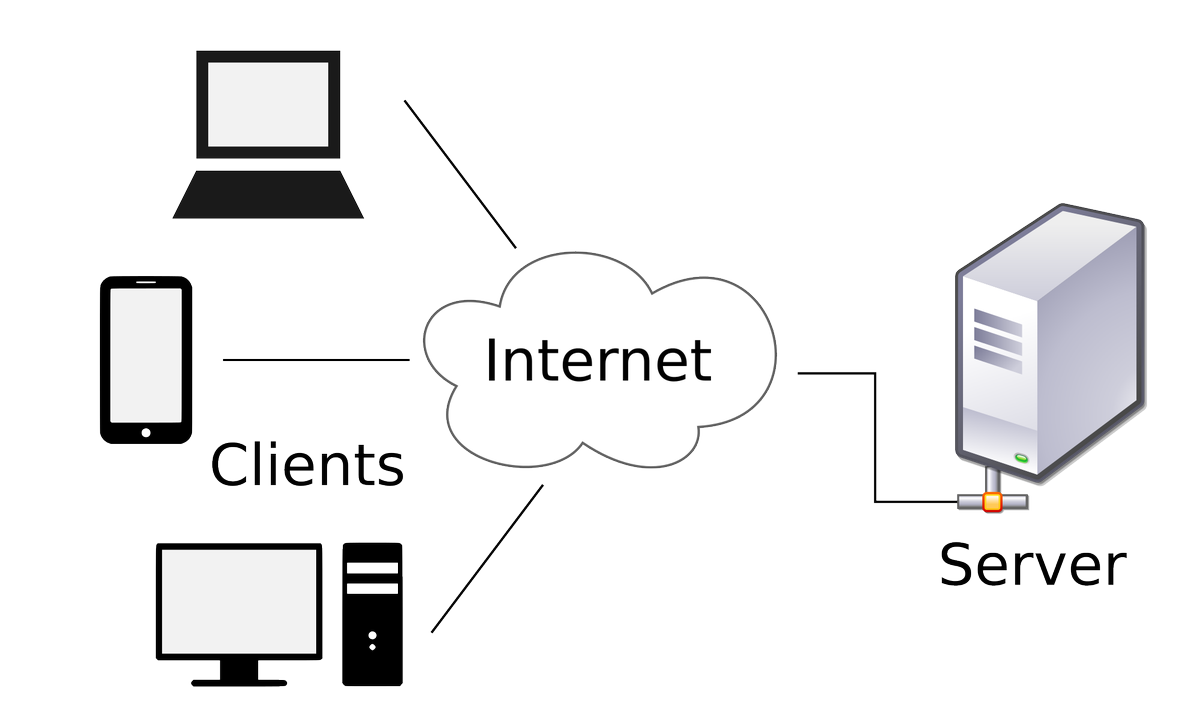

В традиционных динамических веб-сайтах, веб-приложение ожидает HTTP-запроса от веб-браузера (или другого клиента). Когда запрос получен, приложение определяет, какое действие необходимо выполнить на основе URL шаблна и, возможно, связанной информации, содержащейся в данных POST или GET. В зависимости от того, что требуется, Express может затем читать или записывать данные из/в базы данных или выполнять другие задачи, в соответствии с полученным запросом. Затем приложение возвращает ответ в веб-браузер, зачастую динамически создавая HTML страницу для отображения браузером, вставляя извлеченные данные в заполнители HTML шаблона.

Express предоставляет методы позволяющие указать, какая функция вызывается для конкретного HTTP запроса (GET, POST, SET, etc. ), и URL шаблон («Route»), а также методы позволяющие указать, какой механизм шаблона («view») используется, где находятся шаблоныы файлов и какой шаблон использовать для вывода ответа. Вы можете использовать Express middleware для добавления поддержки файлов cookies, сеансов, и пользователей, получения

), и URL шаблон («Route»), а также методы позволяющие указать, какой механизм шаблона («view») используется, где находятся шаблоныы файлов и какой шаблон использовать для вывода ответа. Вы можете использовать Express middleware для добавления поддержки файлов cookies, сеансов, и пользователей, получения POST/GET параметров, и т.д. Вы можете использовать любой механизм базы данных, поддерживаемый Node (Express не определяет поведение, связанное с базой данных).

В следующих разделах объясняются некоторые общие моменты, которые вы увидите при работе с кодом Express and Node.

Helloworld Express

Сначала давайте рассмотрим стандартный пример Express Hello World (мы обсудим каждую часть этого ниже и в следующих разделах).

Совет: Если у вас уже установлены Node и Express (или если вы устанавливаете их, как показано в следующей статье), вы можете сохранить этот код в файле с именем app.js и запустить его в командной строке, вызвав узел app. js. отражения).

js. отражения).

var express = require('express');

var app = express();

app.get('/', function(req, res) {

res.send('Hello World!');

});

app.listen(3000, function() {

console.log('Example app listening on port 3000!');

});

Первые две строки требуют () (импорт) модуля Express и создания приложения Express. Этот объект, который традиционно называется app, имеет методы для маршрутизации HTTP-запросов, настройки промежуточного программного обеспечения, рендеринга представлений HTML, регистрации механизма шаблонов и изменения параметров приложения, которые управляют поведением приложения (например, режим среды, чувствительны ли определения маршрута к регистру). , и т.д.)

Средняя часть кода (три строки, начинающиеся с app.get) показывает определение маршрута. Метод app.get () указывает функцию обратного вызова, которая будет вызываться всякий раз, когда есть HTTP-запрос GET с путем (‘/’) относительно корня сайта. Функция обратного вызова принимает запрос и объект ответа в качестве аргументов и просто вызывает send () для ответа, чтобы вернуть строку «Hello World!»

Последний блок запускает сервер через порт «3000» и печатает комментарий журнала в консоль. Когда сервер работает, вы можете перейти к localhost: 3000 в вашем браузере, чтобы увидеть возвращенный пример ответа.

Когда сервер работает, вы можете перейти к localhost: 3000 в вашем браузере, чтобы увидеть возвращенный пример ответа.

Импорт и создание модулей

Модуль — это библиотека / файл JavaScript, который вы можете импортировать в другой код с помощью функции require () Node. Express сам по себе является модулем, как и промежуточное программное обеспечение и библиотеки баз данных, которые мы используем в наших приложениях Express.

Приведенный ниже код показывает, как мы импортируем модуль по имени, используя в качестве примера платформу Express. Сначала мы вызываем функцию require (), определяя имя модуля в виде строки («express») и вызывая возвращенный объект для создания приложения Express. Затем мы можем получить доступ к свойствам и функциям объекта приложения.

var express = require('express');

var app = express();

Вы также можете создавать свои собственные модули, которые можно импортировать таким же образом.

Совет: вы захотите создать свои собственные модули, потому что это позволяет вам организовать ваш код в управляемые части — монолитное однофайловое приложение трудно понять и поддерживать. Использование модулей также помогает вам управлять пространством имен, поскольку при использовании модуля импортируются только те переменные, которые вы явно экспортировали.

Использование модулей также помогает вам управлять пространством имен, поскольку при использовании модуля импортируются только те переменные, которые вы явно экспортировали.

Чтобы сделать объекты доступными вне модуля, вам просто нужно назначить их объекту экспорта. Например, модуль square.js ниже представляет собой файл, который экспортирует методы area () и perimeter ():

exports.area = function(width) { return width * width; };

exports.perimeter = function(width) { return 4 * width; };

Мы можем импортировать этот модуль, используя require (), а затем вызвать экспортированные методы, как показано:

var square = require('./square');

console.log('The area of a square with a width of 4 is ' + square.area(4));Примечание. Вы также можете указать абсолютный путь к модулю (или имя, как мы делали изначально).

Если вы хотите экспортировать полный объект в одном назначении, а не создавать его по одному свойству за раз, назначьте его для module. exports, как показано ниже (вы также можете сделать это, чтобы сделать корень объекта экспорта конструктором или другой функцией) :

exports, как показано ниже (вы также можете сделать это, чтобы сделать корень объекта экспорта конструктором или другой функцией) :

module.exports = {

area: function(width) {

return width * width;

},

perimeter: function(width) {

return 4 * width;

}

};

Для получения дополнительной информации о модулях см. Modules (Node API docs).

Использование асинхронных API

Код JavaScript часто использует асинхронные, а не синхронные API для операций, выполнение которых может занять некоторое время. Синхронный API — это тот, в котором каждая операция должна завершиться до начала следующей операции. Например, следующие функции журнала являются синхронными и выводят текст на консоль по порядку (первый, второй).

console.log('First');

console.log('Second');

В отличие от этого, асинхронный API — это тот, в котором API начнет операцию и сразу же вернется (до завершения операции). После завершения операции API будет использовать некоторый механизм для выполнения дополнительных операций. Например, приведенный ниже код выведет «Second, First», потому что хотя метод setTimeout () вызывается первым и возвращается немедленно, операция не завершается в течение нескольких секунд.

Например, приведенный ниже код выведет «Second, First», потому что хотя метод setTimeout () вызывается первым и возвращается немедленно, операция не завершается в течение нескольких секунд.

setTimeout(function() {

console.log('First');

}, 3000);

console.log('Second');

Использование неблокирующих асинхронных API-интерфейсов еще более важно в Node, чем в браузере, поскольку Node — это однопоточная среда выполнения, управляемая событиями. «Однопоточный» означает, что все запросы к серверу выполняются в одном потоке (а не порождаются в отдельных процессах). Эта модель чрезвычайно эффективна с точки зрения скорости и ресурсов сервера, но это означает, что если любая из ваших функций вызывает синхронные методы, выполнение которых занимает много времени, они будут блокировать не только текущий запрос, но и любой другой запрос, обрабатываемый ваше веб-приложение.

Есть несколько способов, которыми асинхронный API уведомляет ваше приложение о том, что оно завершено. Наиболее распространенный способ — зарегистрировать функцию обратного вызова при вызове асинхронного API, который будет вызываться после завершения операции. Это подход, использованный выше.

Наиболее распространенный способ — зарегистрировать функцию обратного вызова при вызове асинхронного API, который будет вызываться после завершения операции. Это подход, использованный выше.

Совет: Использование обратных вызовов может быть довольно «грязным», если у вас есть последовательность зависимых асинхронных операций, которые должны выполняться по порядку, потому что это приводит к нескольким уровням вложенных обратных вызовов. Эта проблема широко известна как «ад обратного вызова». Эту проблему можно решить с помощью хороших методов кодирования (см. Http://callbackhell.com/), использования такого модуля, как async, или даже перехода к функциям ES6, таким как Promises.

Примечание. Общим соглашением для Node и Express является использование обратных вызовов с ошибками. В этом соглашении первое значение в ваших функциях обратного вызова является значением ошибки, в то время как последующие аргументы содержат данные об успехе. В этом блоге есть хорошее объяснение того, почему этот подход полезен: путь Node. js — понимание обратных вызовов с ошибками (fredkschott.com).

js — понимание обратных вызовов с ошибками (fredkschott.com).

Создание обработчиков маршрута

В нашем примере Hello World Express (см. Выше) мы определили функцию обработчика маршрута (обратного вызова) для HTTP-запросов GET к корню сайта (‘/’).

app.get('/', function(req, res) {

res.send('Hello World!');

});

Функция обратного вызова принимает запрос и объект ответа в качестве аргументов. В этом случае метод просто вызывает send () в ответе, чтобы вернуть строку «Hello World!» Существует ряд других методов ответа для завершения цикла запрос / ответ, например, вы можете вызвать res.json () для отправки ответа JSON или res.sendFile () для отправки файла.

Совет по JavaScript: вы можете использовать любые имена аргументов, которые вам нравятся, в функциях обратного вызова; при вызове обратного вызова первый аргумент всегда будет запросом, а второй всегда будет ответом. Имеет смысл назвать их так, чтобы вы могли идентифицировать объект, с которым работаете, в теле обратного вызова.

Объект приложения Express также предоставляет методы для определения обработчиков маршрутов для всех других HTTP-глаголов, которые в основном используются одинаково: post (), put (), delete (), options (), trace (), copy ( ), lock (), mkcol (), move (), purge (), propfind (), proppatch (), unlock (), report (), mkactivity (), checkout (), merge ( ), m-search (), notify (), subscribe (), unsubscribe (), patch (), search () и connect ().

Существует специальный метод маршрутизации app.all (), который будет вызываться в ответ на любой метод HTTP. Это используется для загрузки функций промежуточного программного обеспечения по определенному пути для всех методов запроса. В следующем примере (из документации Express) показан обработчик, который будет выполняться для запросов к / secret независимо от используемого глагола HTTP (при условии, что он поддерживается модулем http).

app.all('/secret', function(req, res, next) {

console.log('Accessing the secret section . ..');

next();

});

..');

next();

});Маршруты позволяют сопоставлять определенные шаблоны символов в URL-адресе, извлекать некоторые значения из URL-адреса и передавать их в качестве параметров обработчику маршрута (в качестве атрибутов объекта запроса, передаваемого в качестве параметра).

Часто полезно группировать обработчики маршрутов для определенной части сайта и получать к ним доступ с помощью общего префикса маршрута (например, сайт с вики может иметь все связанные с вики маршруты в одном файле и иметь к ним доступ с префиксом маршрута из / вики /). В Express это достигается с помощью объекта express.Router. Например, мы можем создать наш вики-маршрут в модуле с именем wiki.js, а затем экспортировать объект Router, как показано ниже:

var express = require('express');

var router = express.Router();

router.get('/', function(req, res) {

res.send('Wiki home page');

});

router.get('/about', function(req, res) {

res.send('About this wiki');

});

module. exports = router;

exports = router;

Примечание. Добавление маршрутов к объекту Router аналогично добавлению маршрутов к объекту приложения (как показано ранее).

Чтобы использовать маршрутизатор в нашем главном файле приложения, нам потребуется () модуль route (wiki.js), а затем вызовите use () в приложении Express, чтобы добавить маршрутизатор в путь обработки промежуточного программного обеспечения. Эти два маршрута будут доступны из / wiki / и / wiki / about /.

var wiki = require('./wiki.js');

app.use('/wiki', wiki);Мы покажем вам намного больше о работе с маршрутами, и в частности об использовании маршрутизатора, позже в связанном разделе Routes and controllers .

Использование промежуточного программного обеспечения

Промежуточное программное обеспечение широко используется в приложениях Express для задач от обслуживания статических файлов до обработки ошибок и сжатия HTTP-ответов. Принимая во внимание, что функции маршрута заканчивают цикл запроса-ответа HTTP, возвращая некоторый ответ клиенту HTTP, функции промежуточного программного обеспечения обычно выполняют некоторую операцию над запросом или ответом и затем вызывают следующую функцию в «стеке», которая может быть большим количеством промежуточного программного обеспечения или маршрута обработчик. Порядок вызова промежуточного программного обеспечения зависит от разработчика приложения.

Порядок вызова промежуточного программного обеспечения зависит от разработчика приложения.

Примечание. Промежуточное программное обеспечение может выполнять любую операцию, выполнять любой код, вносить изменения в объект запроса и ответа, а также может завершать цикл запрос-ответ. Если он не завершает цикл, он должен вызвать next (), чтобы передать управление следующей функции промежуточного программного обеспечения (или запрос останется зависшим).

Большинство приложений используют стороннее промежуточное программное обеспечение для упрощения общих задач веб-разработки, таких как работа с файлами cookie, сессиями, аутентификацией пользователя, доступом к данным запросов POST и JSON, ведение журнала и т. д. Список пакетов промежуточного программного обеспечения, поддерживаемых командой Express, можно найти. (который также включает в себя другие популярные сторонние пакеты). Другие экспресс-пакеты доступны в диспетчере пакетов NPM.

Для использования стороннего промежуточного программного обеспечения сначала необходимо установить его в свое приложение с помощью NPM. Например, чтобы установить промежуточное программное обеспечение средства регистрации HTTP-запросов morgan, вы должны сделать следующее:

Например, чтобы установить промежуточное программное обеспечение средства регистрации HTTP-запросов morgan, вы должны сделать следующее:

$ npm install morgan

Затем вы можете вызвать use () для объекта приложения Express, чтобы добавить промежуточное программное обеспечение в стек:

var express = require('express');

var logger = require('morgan');

var app = express();

app.use(logger('dev'));

...Примечание. Промежуточное программное обеспечение и функции маршрутизации вызываются в том порядке, в котором они были объявлены. Для некоторого промежуточного программного обеспечения важен порядок (например, если промежуточное программное обеспечение сеанса зависит от промежуточного программного обеспечения cookie, то сначала должен быть добавлен обработчик cookie). Почти всегда случается так, что промежуточное ПО вызывается перед настройкой маршрутов, иначе ваши обработчики маршрутов не будут иметь доступа к функциям, добавленным вашим промежуточным ПО.

Вы можете написать свои собственные функции промежуточного программного обеспечения, и вам, вероятно, придется это сделать (хотя бы для создания кода обработки ошибок). Единственное различие между функцией промежуточного программного обеспечения и обратным вызовом обработчика маршрута состоит в том, что функции промежуточного программного обеспечения имеют третий аргумент, следующий: какие функции промежуточного программного обеспечения должны вызываться, если они не завершают цикл запроса (когда вызывается функция промежуточного программного обеспечения, она содержит следующую функцию). это надо называть).

Вы можете добавить функцию промежуточного программного обеспечения в цепочку обработки с помощью app.use () или app.add (), в зависимости от того, хотите ли вы применить промежуточное программное обеспечение ко всем ответам или к ответам с определенным глаголом HTTP (GET, POST и т. д.). ). Маршруты задаются одинаково в обоих случаях, хотя маршрут необязателен при вызове app. use ().

use ().

В приведенном ниже примере показано, как можно добавить функцию промежуточного программного обеспечения, используя оба метода, а также с / без маршрута.

var express = require('express');

var app = express();

var a_middleware_function = function(req, res, next) {

next();

}

app.use(a_middleware_function);

app.use('/someroute', a_middleware_function);

app.get('/', a_middleware_function);

app.listen(3000);Совет по JavaScript: выше мы объявляем функцию промежуточного программного обеспечения отдельно, а затем устанавливаем ее в качестве обратного вызова. В нашей предыдущей функции обработчика маршрута мы объявили функцию обратного вызова, когда она использовалась. В JavaScript любой подход является допустимым.

Документация по Express содержит намного больше отличной информации по использованию и написанию промежуточного программного обеспечения Express.

Обслуживание статических файлов

Вы можете использовать промежуточное программное обеспечение express. static для обслуживания статических файлов, включая ваши изображения, CSS и JavaScript (static () — единственная функция промежуточного программного обеспечения, которая фактически является частью Express). Например, вы должны использовать строку ниже для обслуживания изображений, файлов CSS и файлов JavaScript из каталога с именем public на том же уровне, где вы вызываете узел:

static для обслуживания статических файлов, включая ваши изображения, CSS и JavaScript (static () — единственная функция промежуточного программного обеспечения, которая фактически является частью Express). Например, вы должны использовать строку ниже для обслуживания изображений, файлов CSS и файлов JavaScript из каталога с именем public на том же уровне, где вы вызываете узел:

app.use(express.static('public'));

Любые файлы в публичном каталоге обслуживаются путем добавления их имени файла (относительно базового «публичного» каталога) к базовому URL. Так, например:

http://localhost:3000/images/dog.jpg

http://localhost:3000/css/style.css

http://localhost:3000/js/app.js

http://localhost:3000/about.html

Вы можете вызывать static () несколько раз для обслуживания нескольких каталогов. Если файл не может быть найден одной функцией промежуточного программного обеспечения, он будет просто передан последующему промежуточному программному обеспечению (порядок вызова промежуточного программного обеспечения основан на вашем порядке объявления).

app.use(express.static('public'));

app.use(express.static('media'));

Вы также можете создать виртуальный префикс для ваших статических URL-адресов, вместо добавления файлов к базовому URL-адресу. Например, здесь мы указываем путь монтирования, чтобы файлы загружались с префиксом «/ media»:

app.use('/media', express.static('public'));

Теперь вы можете загружать файлы, находящиеся в публичном каталоге, из префикса / media path.

http://localhost:3000/media/images/dog.jpg

http://localhost:3000/media/cry.mp3

Для получения дополнительной информации см. Serving static files in Express.

Обработка ошибок

Ошибки обрабатываются одной или несколькими специальными функциями промежуточного программного обеспечения, которые имеют четыре аргумента вместо обычных трех: (err, req, res, next). Например:

app.use(function(err, req, res, next) {

console. error(err.stack);

res.status(500).send('Something broke!');

});

error(err.stack);

res.status(500).send('Something broke!');

});

Они могут возвращать любой требуемый контент, но должны вызываться после всех других app.use () и маршрутизировать вызовы, чтобы они были последним промежуточным ПО в процессе обработки запросов!

Express поставляется со встроенным обработчиком ошибок, который заботится обо всех оставшихся ошибках, которые могут возникнуть в приложении. Эта промежуточная функция обработки ошибок по умолчанию добавляется в конец стека функций промежуточного программного обеспечения. Если вы передаете ошибку в next () и не обрабатываете ее в обработчике ошибок, она будет обработана встроенным обработчиком ошибок; ошибка будет записана клиенту с трассировкой стека.

Примечание. Трассировка стека не включена в производственную среду. Чтобы запустить его в производственном режиме, необходимо установить переменную среды NODE_ENV в «производство».

Примечание. HTTP404 и другие коды состояния «ошибка» не считаются ошибками. Если вы хотите справиться с этим, вы можете добавить функцию промежуточного программного обеспечения для этого. Для получения дополнительной информации см. FAQ.

Если вы хотите справиться с этим, вы можете добавить функцию промежуточного программного обеспечения для этого. Для получения дополнительной информации см. FAQ.

Для получения дополнительной информации см. Error handling (Express docs).

Использование баз данных

Приложения Express могут использовать любой механизм базы данных, поддерживаемый Node (сам по себе Express не определяет каких-либо дополнительных действий / требований для управления базой данных). Есть много вариантов, включая PostgreSQL, MySQL, Redis, SQLite, MongoDB и т. Д.

Чтобы использовать их, вы должны сначала установить драйвер базы данных, используя NPM. Например, чтобы установить драйвер для популярной NoSQL MongoDB, вы должны использовать команду:

$ npm install mongodb

Сама база данных может быть установлена локально или на облачном сервере. В вашем экспресс-коде вам требуется драйвер, подключиться к базе данных, а затем выполнить операции создания, чтения, обновления и удаления (CRUD). Пример ниже (из документации Express) показывает, как вы можете найти записи «млекопитающих», используя MongoDB.

Пример ниже (из документации Express) показывает, как вы можете найти записи «млекопитающих», используя MongoDB.

var MongoClient = require('mongodb').MongoClient;

MongoClient.connect('mongodb://localhost:27017/animals', function(err, db) {

if (err) throw err;

db.collection('mammals').find().toArray(function (err, result) {

if (err) throw err;

console.log(result);

});

});Другим популярным подходом является косвенный доступ к вашей базе данных с помощью Object Relational Mapper («ORM»). При таком подходе вы определяете свои данные как «объекты» или «модели», и ORM отображает их в базовый формат базы данных. Этот подход имеет то преимущество, что как разработчик вы можете продолжать думать с точки зрения объектов JavaScript, а не семантики базы данных, и что есть очевидное место для выполнения проверки и проверки входящих данных. Подробнее о базах данных мы поговорим в следующей статье.

Для получения дополнительной информации см. Database integration (Express docs).

Рендеринг данных (просмотров)

Механизмы шаблонов (в Express называемые «механизмами просмотра») позволяют указывать структуру выходного документа в шаблоне, используя заполнители для данных, которые будут заполняться при создании страницы. Шаблоны часто используются для создания HTML, но могут также создавать другие типы документов. В Express есть поддержка ряда шаблонных движков, и здесь есть полезное сравнение более популярных движков: Сравнение шаблонизаторов JavaScript: Jade, Mustache, Dust и More.

В своем коде настроек приложения вы задаете механизм шаблонов для использования и место, где Express должен искать шаблоны, используя настройки «views» и «engine», как показано ниже (вам также нужно будет установить пакет, содержащий вашу библиотеку шаблонов). !)

var express = require('express');

var app = express();

app.set('views', path.join(__dirname, 'views'));

app.set('view engine', 'some_template_engine_name');

Внешний вид шаблона будет зависеть от того, какой движок вы используете. Предполагая, что у вас есть файл шаблона с именем «index. <Template_extension>», который содержит заполнители для переменных данных с именами «title» и «message», вы должны вызвать Response.render () в функции обработчика маршрута для создания и отправки ответа HTML. :

Предполагая, что у вас есть файл шаблона с именем «index. <Template_extension>», который содержит заполнители для переменных данных с именами «title» и «message», вы должны вызвать Response.render () в функции обработчика маршрута для создания и отправки ответа HTML. :

app.get('/', function(req, res) {

res.render('index', { title: 'About dogs', message: 'Dogs rock!' });

});Для получения дополнительной информации см. Using template engines with Express (Express docs).

Файловая структура

Express не делает никаких предположений относительно структуры или компонентов, которые вы используете. Маршруты, представления, статические файлы и другая логика конкретного приложения могут находиться в любом количестве файлов с любой структурой каталогов. Хотя вполне возможно иметь все приложения Express в одном файле, обычно имеет смысл разделить ваше приложение на файлы на основе функций (например, управление учетными записями, блоги, доски обсуждений) и проблемной области архитектуры (например, модель, представление или контроллер, если вы случайно используете MVC architecture).

В более поздней теме мы будем использовать Express Application Generator, который создает модульный каркас приложения, который мы можем легко расширить для создания веб-приложений.

Поздравляем, вы завершили первый шаг в своем путешествии Express / Node! Теперь вы должны понимать основные преимущества Express и Node, а также примерно то, как могут выглядеть основные части приложения Express (маршруты, промежуточное ПО, обработка ошибок и код шаблона). Вы также должны понимать, что с Express, который является непонятным фреймворком, то, как вы собираете эти части вместе, и библиотеки, которые вы используете, в значительной степени зависит от вас!

Конечно, Express — это очень легкая платформа для веб-приложений, поэтому большая часть ее преимуществ и возможностей обеспечивается сторонними библиотеками и функциями. Мы рассмотрим это более подробно в следующих статьях. В нашей следующей статье мы рассмотрим настройку среды разработки Node, чтобы вы могли увидеть некоторый код Express в действии.

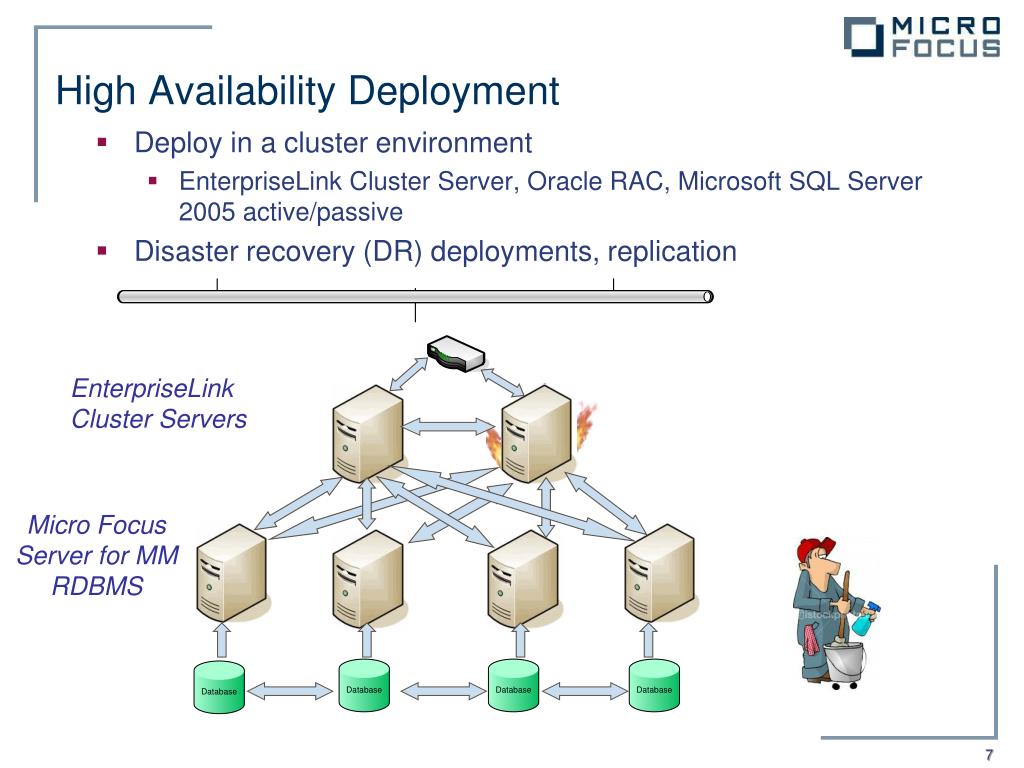

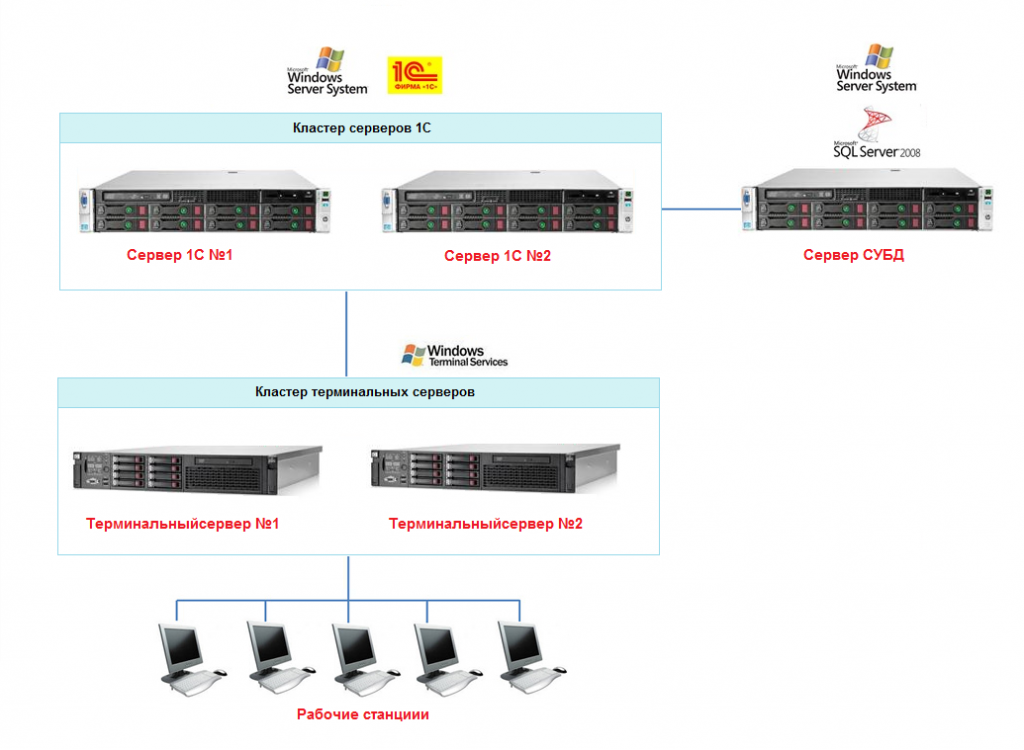

Развертывание кластеризованного файлового сервера с двумя узлами

- Чтение занимает 18 мин

В этой статье

Применяется к: Windows Server 2019, Windows Server 2016Applies to: Windows Server 2019, Windows Server 2016

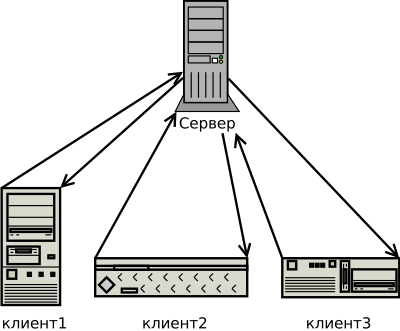

Отказоустойчивый кластер — это группа независимых компьютеров, совместная работа которых позволяет повысить доступность приложений и служб.A failover cluster is a group of independent computers that work together to increase the availability of applications and services. Кластерные серверы (называемые «узлы») соединены физическими кабелями и программным обеспечением.The clustered servers (called nodes) are connected by physical cables and by software. При сбое на одном из узлов кластера его функции немедленно передаются другому узлу (этот процесс называется отработкой отказа).If one of the cluster nodes fails, another node begins to provide service (a process known as failover). В службе можно столкнуться с минимальными нарушениями.Users experience a minimum of disruptions in service.

При сбое на одном из узлов кластера его функции немедленно передаются другому узлу (этот процесс называется отработкой отказа).If one of the cluster nodes fails, another node begins to provide service (a process known as failover). В службе можно столкнуться с минимальными нарушениями.Users experience a minimum of disruptions in service.

В этом руководстве описаны шаги по установке и настройке отказоустойчивого кластера файлового сервера общего назначения с двумя узлами.This guide describes the steps for installing and configuring a general purpose file server failover cluster that has two nodes. Создавая конфигурацию в этом руководство, вы можете изучить отказоустойчивые кластеры и ознакомиться с интерфейсом оснастки управления отказоустойчивыми кластерами в Windows Server 2019 или Windows Server 2016.By creating the configuration in this guide, you can learn about failover clusters and familiarize yourself with the Failover Cluster Management snap-in interface in Windows Server 2019 or Windows Server 2016.

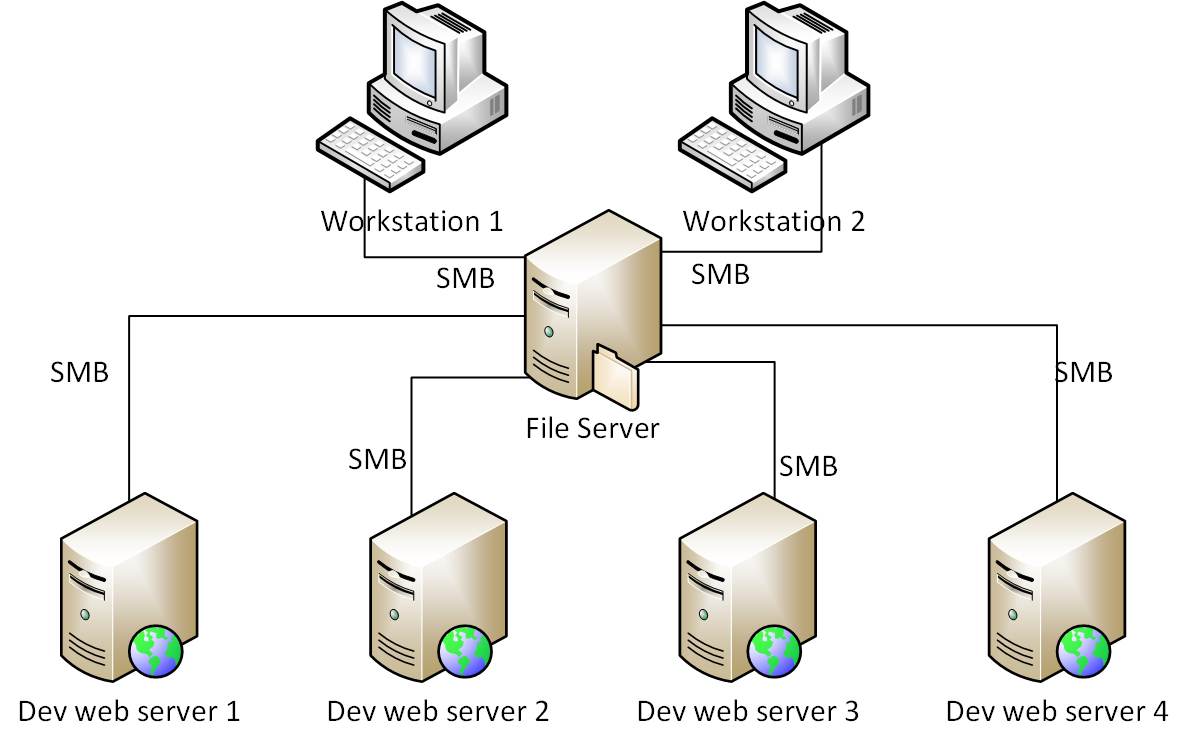

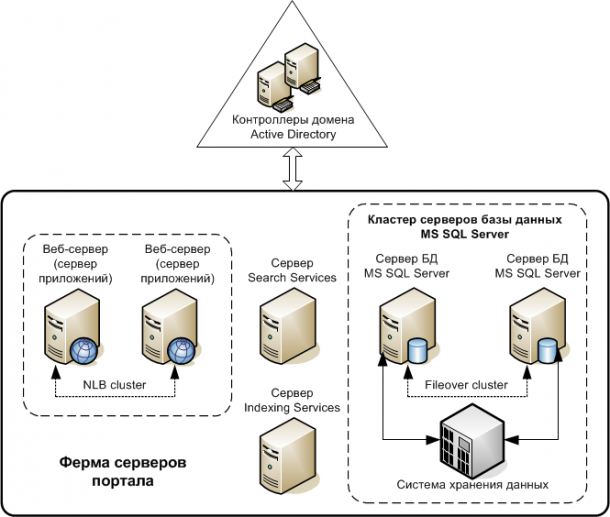

Общие сведения о кластере файлового сервера с двумя узламиOverview for a two-node file server cluster

Серверы в отказоустойчивом кластере могут работать в различных ролях, включая роли файлового сервера, сервера Hyper-V или сервера базы данных, а также обеспечивают высокий уровень доступности для различных служб и приложений.Servers in a failover cluster can function in a variety of roles, including the roles of file server, Hyper-V server, or database server, and can provide high availability for a variety of other services and applications. В этом руководство описано, как настроить кластер файлового сервера с двумя узлами.This guide describes how to configure a two-node file server cluster.

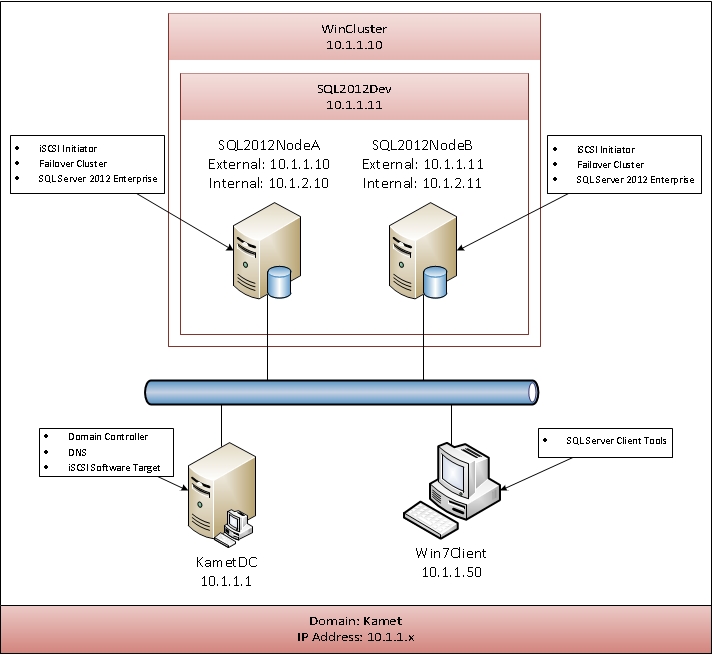

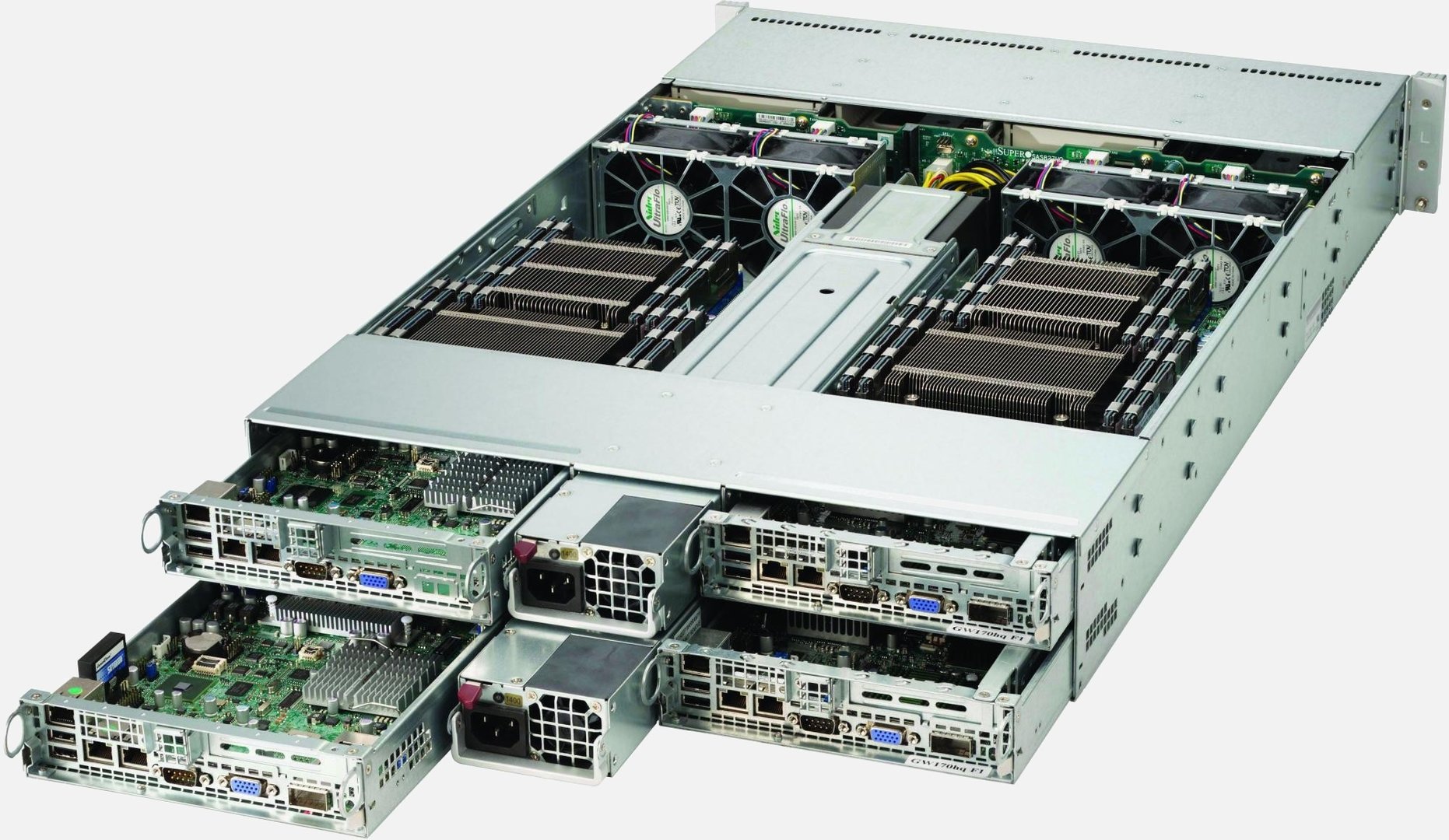

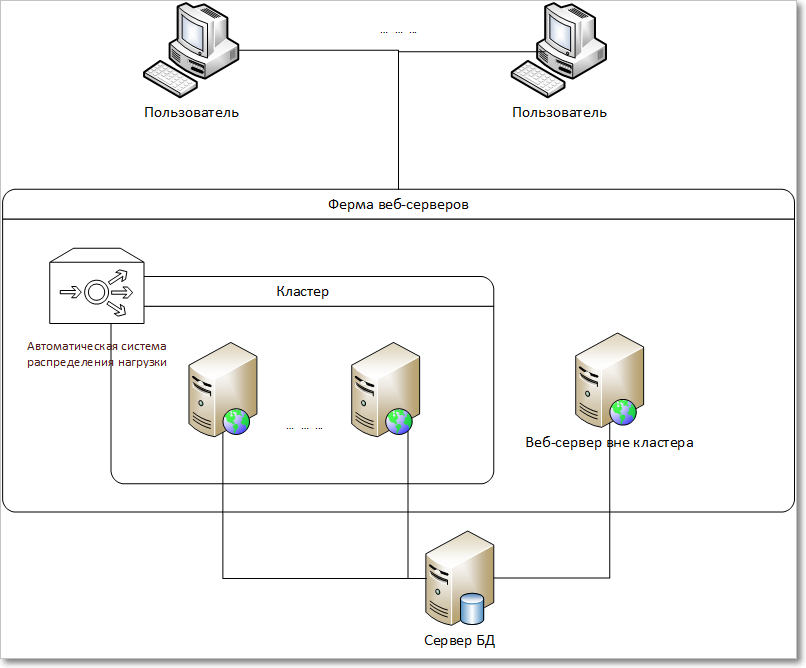

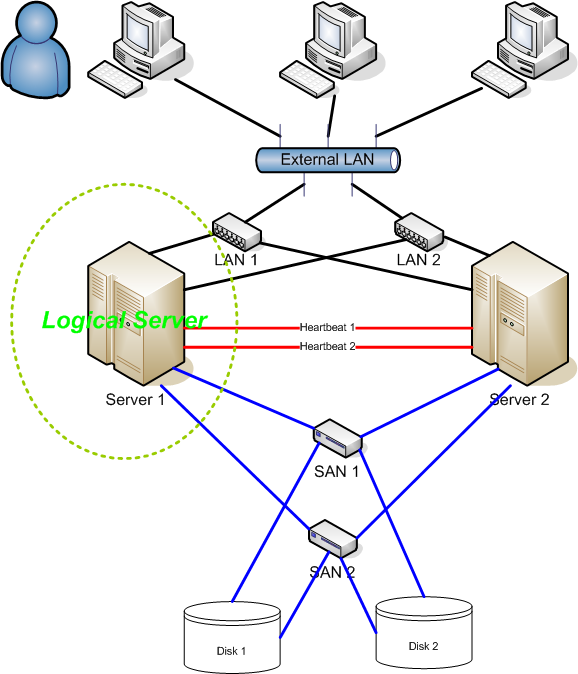

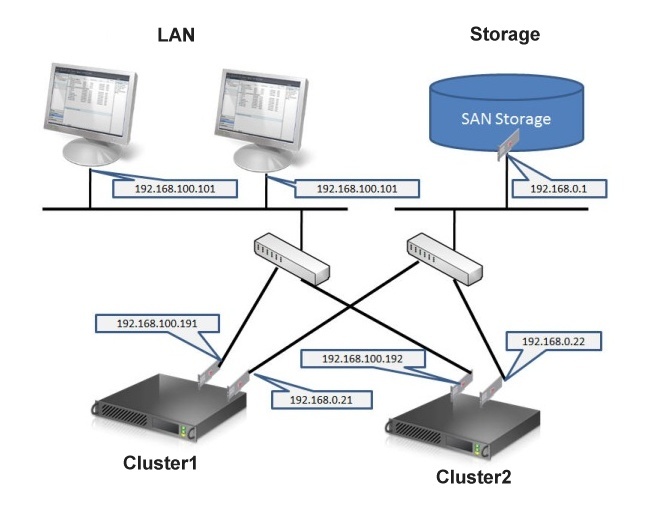

Отказоустойчивый кластер обычно включает в себя единицу хранения, которая физически подключена ко всем серверам в кластере, хотя каждый заданный том в хранилище доступен только одному серверу за раз.A failover cluster usually includes a storage unit that is physically connected to all the servers in the cluster, although any given volume in the storage is only accessed by one server at a time. На следующей схеме показан отказоустойчивый кластер с двумя узлами, подключенный к единице хранения.The following diagram shows a two-node failover cluster connected to a storage unit.

На следующей схеме показан отказоустойчивый кластер с двумя узлами, подключенный к единице хранения.The following diagram shows a two-node failover cluster connected to a storage unit.

Тома хранилища или логические номера устройств (LUN), предоставляемые узлам в кластере, не должны предоставляться другим серверам, включая серверы в другом кластере.Storage volumes or logical unit numbers (LUNs) exposed to the nodes in a cluster must not be exposed to other servers, including servers in another cluster. Это показано на схеме ниже.The following diagram illustrates this.

Обратите внимание, что для обеспечения максимальной доступности любого сервера важно следовать рекомендациям по управлению сервером, например, тщательному управлению физической средой серверов, тестированию изменений программного обеспечения перед их полным внедрением и тщательно отслеживать обновления программного обеспечения и изменения конфигурации на всех кластеризованных серверах.Note that for the maximum availability of any server, it is important to follow best practices for server management—for example, carefully managing the physical environment of the servers, testing software changes before fully implementing them, and carefully keeping track of software updates and configuration changes on all clustered servers.

В следующем сценарии описано, как можно настроить отказоустойчивый кластер файлового сервера.The following scenario describes how a file server failover cluster can be configured. Общие файлы находятся в хранилище кластера, а кластеризованный сервер может работать как файловый сервер, который их использует.The files being shared are on the cluster storage, and either clustered server can act as the file server that shares them.

Общие папки в отказоустойчивом кластереShared folders in a failover cluster

В следующем списке описаны функции конфигурации общих папок, интегрированные в отказоустойчивую кластеризацию.The following list describes shared folder configuration functionality that is integrated into failover clustering:

Область отображения ограничена только кластеризованными общими папками (без смешивания с некластеризованными общими папками). когда пользователь просматривает общие папки, указывая путь к кластеризованному файловому серверу, на экран будут включены только общие папки, которые являются частью конкретной роли файлового сервера.

Display is scoped to clustered shared folders only (no mixing with non-clustered shared folders): When a user views shared folders by specifying the path of a clustered file server, the display will include only the shared folders that are part of the specific file server role. Она будет исключать некластеризованные общие папки и использует часть отдельных ролей файлового сервера, которые находятся на узле кластера.It will exclude non-clustered shared folders and shares part of separate file server roles that happen to be on a node of the cluster.

Display is scoped to clustered shared folders only (no mixing with non-clustered shared folders): When a user views shared folders by specifying the path of a clustered file server, the display will include only the shared folders that are part of the specific file server role. Она будет исключать некластеризованные общие папки и использует часть отдельных ролей файлового сервера, которые находятся на узле кластера.It will exclude non-clustered shared folders and shares part of separate file server roles that happen to be on a node of the cluster.Перечисление на основе доступа. можно использовать перечисление на основе доступа, чтобы скрыть указанную папку от представления пользователей.Access-based enumeration: You can use access-based enumeration to hide a specified folder from users’ view. Вместо того чтобы разрешить пользователям просматривать папку, но не обращаться к ней, можно запретить им просматривать папку.Instead of allowing users to see the folder but not access anything on it, you can choose to prevent them from seeing the folder at all.

Перечисление на основе доступа для кластеризованной общей папки можно настроить так же, как и для некластеризованной общей папки.You can configure access-based enumeration for a clustered shared folder in the same way as for a non-clustered shared folder.

Перечисление на основе доступа для кластеризованной общей папки можно настроить так же, как и для некластеризованной общей папки.You can configure access-based enumeration for a clustered shared folder in the same way as for a non-clustered shared folder.Автономный доступ. можно настроить автономный доступ (кэширование) для кластеризованной общей папки таким же образом, как и для некластеризованной общей папки.Offline access: You can configure offline access (caching) for a clustered shared folder in the same way as for a nonclustered shared folder.

Кластерные диски всегда распознаются как часть кластера: независимо от того, используется ли интерфейс отказоустойчивого кластера, проводник или оснастка управления хранилищем, Windows определяет, назначен ли диск в хранилище кластера.Clustered disks are always recognized as part of the cluster: Whether you use the failover cluster interface, Windows Explorer, or the Share and Storage Management snap-in, Windows recognizes whether a disk has been designated as being in the cluster storage.

Если такой диск уже был настроен в оснастке управления отказоустойчивыми кластерами как часть кластеризованного файлового сервера, можно использовать любой из упомянутых выше интерфейсов для создания общего ресурса на диске.If such a disk has already been configured in Failover Cluster Management as part of a clustered file server, you can then use any of the previously mentioned interfaces to create a share on the disk. Если такой диск не был настроен как часть кластеризованного файлового сервера, создать на нем общую папку по ошибке невозможно.If such a disk has not been configured as part of a clustered file server, you cannot mistakenly create a share on it. Вместо этого для предоставления общего доступа необходимо сначала настроить диск в составе кластеризованного файлового сервера.Instead, an error indicates that the disk must first be configured as part of a clustered file server before it can be shared.

Если такой диск уже был настроен в оснастке управления отказоустойчивыми кластерами как часть кластеризованного файлового сервера, можно использовать любой из упомянутых выше интерфейсов для создания общего ресурса на диске.If such a disk has already been configured in Failover Cluster Management as part of a clustered file server, you can then use any of the previously mentioned interfaces to create a share on the disk. Если такой диск не был настроен как часть кластеризованного файлового сервера, создать на нем общую папку по ошибке невозможно.If such a disk has not been configured as part of a clustered file server, you cannot mistakenly create a share on it. Вместо этого для предоставления общего доступа необходимо сначала настроить диск в составе кластеризованного файлового сервера.Instead, an error indicates that the disk must first be configured as part of a clustered file server before it can be shared.Интеграция служб для сетевой файловой системы. роль файлового сервера в Windows Server включает в себя дополнительную службу ролей под названием службы для NFS.

Integration of Services for Network File System: The File Server role in Windows Server includes the optional role service called Services for Network File System (NFS). Установив службу роли и настроив общие папки с помощью служб для NFS, можно создать кластеризованный файловый сервер, который поддерживает клиенты на базе UNIX.By installing the role service and configuring shared folders with Services for NFS, you can create a clustered file server that supports UNIX-based clients.

Integration of Services for Network File System: The File Server role in Windows Server includes the optional role service called Services for Network File System (NFS). Установив службу роли и настроив общие папки с помощью служб для NFS, можно создать кластеризованный файловый сервер, который поддерживает клиенты на базе UNIX.By installing the role service and configuring shared folders with Services for NFS, you can create a clustered file server that supports UNIX-based clients.

Требования к отказоустойчивому кластеру с двумя узламиRequirements for a two-node failover cluster

Для отказоустойчивого кластера в Windows Server 2016 или Windows Server 2019, который считается официально поддерживаемым решением корпорации Майкрософт, решение должно удовлетворять следующим критериям.For a failover cluster in Windows Server 2016 or Windows Server 2019 to be considered an officially supported solution by Microsoft, the solution must meet the following criteria.

Все компоненты оборудования и программного обеспечения должны отвечать требованиям сертификации для логотипа соответствующей ОС.

All hardware and software components must meet the qualifications for the appropriate logo. Для Windows Server 2016 это логотип «сертифицировано для Windows Server 2016».For Windows Server 2016, this is the «Certified for Windows Server 2016» logo. Для Windows Server 2019 это логотип «сертифицировано для Windows Server 2019».For Windows Server 2019, this is the «Certified for Windows Server 2019» logo. Дополнительные сведения о сертифицированных оборудовании и программном обеспечении см. на веб-сайте каталога Microsoft Windows Server .For more information about what hardware and software systems have been certified, please visit the Microsoft Windows Server Catalog site.

All hardware and software components must meet the qualifications for the appropriate logo. Для Windows Server 2016 это логотип «сертифицировано для Windows Server 2016».For Windows Server 2016, this is the «Certified for Windows Server 2016» logo. Для Windows Server 2019 это логотип «сертифицировано для Windows Server 2019».For Windows Server 2019, this is the «Certified for Windows Server 2019» logo. Дополнительные сведения о сертифицированных оборудовании и программном обеспечении см. на веб-сайте каталога Microsoft Windows Server .For more information about what hardware and software systems have been certified, please visit the Microsoft Windows Server Catalog site.Полностью настроенное решение (серверы, сеть и хранилище) должно пройти все тесты в мастере проверки, который является частью оснастки отказоустойчивого кластера.The fully configured solution (servers, network, and storage) must pass all tests in the validation wizard, which is part of the failover cluster snap-in.

Для отказоустойчивого кластера с двумя узлами необходимо следующее:The following will be needed for a two-node failover cluster.

Серверы: Рекомендуется использовать совпадающие компьютеры с одинаковыми или аналогичными компонентами.Servers: We recommend using matching computers with the same or similar components. Серверы для отказоустойчивого кластера с двумя узлами должны работать под управлением одной и той же версии Windows Server.The servers for a two-node failover cluster must run the same version of Windows Server. Они также должны иметь одинаковые обновления программного обеспечения (исправления).They should also have the same software updates (patches).

Сетевые адаптеры и кабель: Сетевое оборудование, как и другие компоненты решения отказоустойчивого кластера, должно быть совместимо с Windows Server 2016 или Windows Server 2019.Network Adapters and cable: The network hardware, like other components in the failover cluster solution, must be compatible with Windows Server 2016 or Windows Server 2019.

При использовании iSCSI сетевые адаптеры должны быть выделены для сетевого взаимодействия или iSCSI, а не для обоих.If you use iSCSI, the network adapters must be dedicated to either network communication or iSCSI, not both. Избегайте единственных точек отказа в сетевой инфраструктуре, соединяющей узлы кластера.In the network infrastructure that connects your cluster nodes, avoid having single points of failure. Это достигается несколькими способами.There are multiple ways of accomplishing this. Вы можете подключать узлы кластера к разным сетям.You can connect your cluster nodes by multiple, distinct networks. Можно также соединить узлы кластера в одну сеть, основанную на сгруппированных сетевых адаптерах, дублированных коммутаторах и маршрутизаторах и аналогичном оборудовании, исключающем появление единственных точек отказа.Alternatively, you can connect your cluster nodes with one network that is constructed with teamed network adapters, redundant switches, redundant routers, or similar hardware that removes single points of failure.

При использовании iSCSI сетевые адаптеры должны быть выделены для сетевого взаимодействия или iSCSI, а не для обоих.If you use iSCSI, the network adapters must be dedicated to either network communication or iSCSI, not both. Избегайте единственных точек отказа в сетевой инфраструктуре, соединяющей узлы кластера.In the network infrastructure that connects your cluster nodes, avoid having single points of failure. Это достигается несколькими способами.There are multiple ways of accomplishing this. Вы можете подключать узлы кластера к разным сетям.You can connect your cluster nodes by multiple, distinct networks. Можно также соединить узлы кластера в одну сеть, основанную на сгруппированных сетевых адаптерах, дублированных коммутаторах и маршрутизаторах и аналогичном оборудовании, исключающем появление единственных точек отказа.Alternatively, you can connect your cluster nodes with one network that is constructed with teamed network adapters, redundant switches, redundant routers, or similar hardware that removes single points of failure.

Примечание

Если узлы кластера подключены к одной сети, сеть будет передавать требование избыточности в мастере проверки конфигурации.If the cluster nodes are connected with a single network, the network will pass the redundancy requirement in the Validate a Configuration wizard. Однако в отчет будет включено предупреждение о том, что сеть не должна иметь единой точки отказа.However, the report will include a warning that the network should not have a single point of failure.

Контроллеры устройств или соответствующие адаптеры для хранилища:Device Controllers or appropriate adapters for storage:

- Последовательный подключенный SCSI или Fibre Channel: Если вы используете последовательный подключенный SCSI или Fibre Channel, во всех кластеризованных серверах все компоненты стека хранилища должны быть идентичными.Serial Attached SCSI or Fibre Channel: If you are using Serial Attached SCSI or Fibre Channel, in all clustered servers, all components of the storage stack should be identical.

Необходимо, чтобы программное обеспечение Multipath I/O (MPIO) и программные компоненты модуля для конкретных устройств (DSM) были идентичными.It is required that the multipath I/O (MPIO) software and Device Specific Module (DSM) software components be identical. Рекомендуется, чтобы контроллеры запоминающих устройств, то есть адаптер шины (HBA), драйверы HBA и встроенное ПО HBA, присоединенные к хранилищу кластера, были идентичными.It is recommended that the mass-storage device controllers—that is, the host bus adapter (HBA), HBA drivers, and HBA firmware—that are attached to cluster storage be identical. При использовании различных HBA следует уточнить у поставщика хранилища, обеспечиваются ли при этом поддерживаемые или рекомендуемые конфигурации.If you use dissimilar HBAs, you should verify with the storage vendor that you are following their supported or recommended configurations.

Необходимо, чтобы программное обеспечение Multipath I/O (MPIO) и программные компоненты модуля для конкретных устройств (DSM) были идентичными.It is required that the multipath I/O (MPIO) software and Device Specific Module (DSM) software components be identical. Рекомендуется, чтобы контроллеры запоминающих устройств, то есть адаптер шины (HBA), драйверы HBA и встроенное ПО HBA, присоединенные к хранилищу кластера, были идентичными.It is recommended that the mass-storage device controllers—that is, the host bus adapter (HBA), HBA drivers, and HBA firmware—that are attached to cluster storage be identical. При использовании различных HBA следует уточнить у поставщика хранилища, обеспечиваются ли при этом поддерживаемые или рекомендуемые конфигурации.If you use dissimilar HBAs, you should verify with the storage vendor that you are following their supported or recommended configurations. - iSCSI: При использовании iSCSI на каждом кластерном сервере должен быть один или несколько сетевых адаптеров или адаптеров шины, выделенных для хранилища ISCSI.

iSCSI: If you are using iSCSI, each clustered server must have one or more network adapters or host bus adapters that are dedicated to the ISCSI storage. Сеть, используемая для iSCSI, не может использоваться для сетевого взаимодействия.The network you use for iSCSI cannot be used for network communication. На всех кластеризованных серверах сетевые адаптеры для подключения к целевому хранилищу iSCSI должны быть одинаковыми. Рекомендуется использовать адаптеры Gigabit Ethernet или с более высокой пропускной способностью.In all clustered servers, the network adapters you use to connect to the iSCSI storage target should be identical, and we recommend that you use Gigabit Ethernet or higher.

iSCSI: If you are using iSCSI, each clustered server must have one or more network adapters or host bus adapters that are dedicated to the ISCSI storage. Сеть, используемая для iSCSI, не может использоваться для сетевого взаимодействия.The network you use for iSCSI cannot be used for network communication. На всех кластеризованных серверах сетевые адаптеры для подключения к целевому хранилищу iSCSI должны быть одинаковыми. Рекомендуется использовать адаптеры Gigabit Ethernet или с более высокой пропускной способностью.In all clustered servers, the network adapters you use to connect to the iSCSI storage target should be identical, and we recommend that you use Gigabit Ethernet or higher.

- Последовательный подключенный SCSI или Fibre Channel: Если вы используете последовательный подключенный SCSI или Fibre Channel, во всех кластеризованных серверах все компоненты стека хранилища должны быть идентичными.Serial Attached SCSI or Fibre Channel: If you are using Serial Attached SCSI or Fibre Channel, in all clustered servers, all components of the storage stack should be identical.

Хранилище: Необходимо использовать общее хранилище, сертифицированное для Windows Server 2016 или Windows Server 2019.Storage: You must use shared storage that is certified for Windows Server 2016 or Windows Server 2019.

Для отказоустойчивого кластера с двумя узлами хранилище должно содержать по крайней мере два отдельных тома (LUN), если для кворума используется диск-свидетель.

For a two-node failover cluster, the storage should contain at least two separate volumes (LUNs) if using a witness disk for quorum. Диск-свидетель — это диск в хранилище кластера, предназначенный для хранения копии базы данных конфигурации кластера.The witness disk is a disk in the cluster storage that is designated to hold a copy of the cluster configuration database. Для этого примера кластера с двумя узлами в качестве конфигурации кворума будет использоваться большинство узлов и дисков.For this two-node cluster example, the quorum configuration will be Node and Disk Majority. Большинство узлов и дисков означает, что узлы и диск-свидетель содержат копии конфигурации кластера, и кластер имеет кворум, если большинство из них (два из трех) этих копий доступны.Node and Disk Majority means that the nodes and the witness disk each contain copies of the cluster configuration, and the cluster has quorum as long as a majority (two out of three) of these copies are available. Другой том (LUN) будет содержать файлы, общие для пользователей.

For a two-node failover cluster, the storage should contain at least two separate volumes (LUNs) if using a witness disk for quorum. Диск-свидетель — это диск в хранилище кластера, предназначенный для хранения копии базы данных конфигурации кластера.The witness disk is a disk in the cluster storage that is designated to hold a copy of the cluster configuration database. Для этого примера кластера с двумя узлами в качестве конфигурации кворума будет использоваться большинство узлов и дисков.For this two-node cluster example, the quorum configuration will be Node and Disk Majority. Большинство узлов и дисков означает, что узлы и диск-свидетель содержат копии конфигурации кластера, и кластер имеет кворум, если большинство из них (два из трех) этих копий доступны.Node and Disk Majority means that the nodes and the witness disk each contain copies of the cluster configuration, and the cluster has quorum as long as a majority (two out of three) of these copies are available. Другой том (LUN) будет содержать файлы, общие для пользователей. The other volume (LUN) will contain the files that are being shared to users.

The other volume (LUN) will contain the files that are being shared to users.К хранилищу предъявляются следующие требования.Storage requirements include the following:

- Для использования собственной поддержки дисков, включенной в компонент отказоустойчивого кластера, применяйте базовые, а не динамические диски.To use the native disk support included in failover clustering, use basic disks, not dynamic disks.

- Рекомендуется отформатировать разделы с файловой системой NTFS (для диска-свидетеля раздел должен быть NTFS).We recommend that you format the partitions with NTFS (for the witness disk, the partition must be NTFS).

- Для разделения диска на разделы можно использовать основную загрузочную запись (MBR) или таблицу разделов GPT.For the partition style of the disk, you can use either master boot record (MBR) or GUID partition table (GPT).

- Хранилище должно правильно реагировать на определенные команды SCSI. хранилище должно соответствовать стандарту, именуемому SCSI PRIMARY Commands-3 (SPC-3).

The storage must respond correctly to specific SCSI commands, the storage must follow the standard called SCSI Primary Commands-3 (SPC-3). В частности, хранилище должно поддерживать постоянные резервирования, как указано в стандарте SPC-3.In particular, the storage must support Persistent Reservations as specified in the SPC-3 standard.

The storage must respond correctly to specific SCSI commands, the storage must follow the standard called SCSI Primary Commands-3 (SPC-3). В частности, хранилище должно поддерживать постоянные резервирования, как указано в стандарте SPC-3.In particular, the storage must support Persistent Reservations as specified in the SPC-3 standard. - Драйвер минипорта, используемый для хранения данных, должен работать с драйвером хранилища Microsoft Storport.The miniport driver used for the storage must work with the Microsoft Storport storage driver.

Развертывание сетей хранения данных с отказоустойчивыми кластерамиDeploying storage area networks with failover clusters

При развертывании сети хранения данных (SAN) с отказоустойчивым кластером следует соблюдать следующие рекомендации.When deploying a storage area network (SAN) with a failover cluster, the following guidelines should be observed.

Подтвердите сертификацию хранилища: С помощью сайта каталога Windows Server убедитесь, что хранилище поставщика, включая драйверы, встроенное по и программное обеспечение, сертифицировано для windows Server 2016 или windows Server 2019.

Confirm certification of the storage: Using the Windows Server Catalog site, confirm the vendor’s storage, including drivers, firmware and software, is certified for Windows Server 2016 or Windows Server 2019.

Confirm certification of the storage: Using the Windows Server Catalog site, confirm the vendor’s storage, including drivers, firmware and software, is certified for Windows Server 2016 or Windows Server 2019.Изоляция устройств хранения данных, один кластер на устройство: Серверы из разных кластеров не должны иметь доступ к одним и тем же устройствам хранения.Isolate storage devices, one cluster per device: Servers from different clusters must not be able to access the same storage devices. В большинстве случаев LUN, используемый для одного набора серверов кластера, должен быть изолирован от всех других серверов через маскирование или зонирование LUN.In most cases, a LUN that is used for one set of cluster servers should be isolated from all other servers through LUN masking or zoning.

Рассмотрите возможность использования программного обеспечения Multipath I/O: В структуре хранилища высокой доступности можно развертывать отказоустойчивые кластеры с несколькими адаптерами шины с помощью программного обеспечения Multipath I/O.

Consider using multipath I/O software: In a highly available storage fabric, you can deploy failover clusters with multiple host bus adapters by using multipath I/O software. Это обеспечивает максимальный уровень резервирования и доступности.This provides the highest level of redundancy and availability. Многопутевое решение должно основываться на Microsoft Multipath I/O (MPIO).The multipath solution must be based on Microsoft Multipath I/O (MPIO). Поставщик оборудования хранилища может предоставить аппаратный модуль MPIO (DSM) для вашего оборудования, хотя Windows Server 2016 и Windows Server 2019 включают один или несколько DSM в составе операционной системы.The storage hardware vendor may supply an MPIO device-specific module (DSM) for your hardware, although Windows Server 2016 and Windows Server 2019 include one or more DSMs as part of the operating system.

Consider using multipath I/O software: In a highly available storage fabric, you can deploy failover clusters with multiple host bus adapters by using multipath I/O software. Это обеспечивает максимальный уровень резервирования и доступности.This provides the highest level of redundancy and availability. Многопутевое решение должно основываться на Microsoft Multipath I/O (MPIO).The multipath solution must be based on Microsoft Multipath I/O (MPIO). Поставщик оборудования хранилища может предоставить аппаратный модуль MPIO (DSM) для вашего оборудования, хотя Windows Server 2016 и Windows Server 2019 включают один или несколько DSM в составе операционной системы.The storage hardware vendor may supply an MPIO device-specific module (DSM) for your hardware, although Windows Server 2016 and Windows Server 2019 include one or more DSMs as part of the operating system.

Требования к сетевой инфраструктуре и учетным записям доменаNetwork infrastructure and domain account requirements

Вам потребуется следующая сетевая инфраструктура для отказоустойчивого кластера с двумя узлами и учетной записи администратора со следующими разрешениями домена:You will need the following network infrastructure for a two-node failover cluster and an administrative account with the following domain permissions:

Сетевые параметры и IP-адреса: При использовании одинаковых сетевых адаптеров для сети также используйте одинаковые параметры связи на этих адаптерах (например, скорость, дуплексный режим, управление потоком и тип носителя).

Network settings and IP addresses: When you use identical network adapters for a network, also use identical communication settings on those adapters (for example, Speed, Duplex Mode, Flow Control, and Media Type). Кроме того, сравните параметры на сетевом адаптере и коммутаторе, к которому он подключается, и убедитесь в том, что они не конфликтуют.Also, compare the settings between the network adapter and the switch it connects to and make sure that no settings are in conflict.

Network settings and IP addresses: When you use identical network adapters for a network, also use identical communication settings on those adapters (for example, Speed, Duplex Mode, Flow Control, and Media Type). Кроме того, сравните параметры на сетевом адаптере и коммутаторе, к которому он подключается, и убедитесь в том, что они не конфликтуют.Also, compare the settings between the network adapter and the switch it connects to and make sure that no settings are in conflict.Если есть частные сети, которые не маршрутизируются в остальную часть сетевой инфраструктуры, убедитесь, что для каждой из этих частных сетей используется уникальная подсеть.If you have private networks that are not routed to the rest of your network infrastructure, ensure that each of these private networks uses a unique subnet. Это необходимо даже в том случае, если каждому сетевому адаптеру присвоен уникальный IP-адрес.This is necessary even if you give each network adapter a unique IP address.

Например, если в центральном офисе есть узел кластера, использующий одну физическую сеть, а в филиале есть другой узел, использующий отдельную физическую сеть, не указывайте адрес 10.0.0.0/24 для обеих сетей, даже если каждому адаптеру присвоен уникальный IP-адрес.For example, if you have a cluster node in a central office that uses one physical network, and another node in a branch office that uses a separate physical network, do not specify 10.0.0.0/24 for both networks, even if you give each adapter a unique IP address.

Например, если в центральном офисе есть узел кластера, использующий одну физическую сеть, а в филиале есть другой узел, использующий отдельную физическую сеть, не указывайте адрес 10.0.0.0/24 для обеих сетей, даже если каждому адаптеру присвоен уникальный IP-адрес.For example, if you have a cluster node in a central office that uses one physical network, and another node in a branch office that uses a separate physical network, do not specify 10.0.0.0/24 for both networks, even if you give each adapter a unique IP address.Дополнительные сведения о сетевых адаптерах см. в разделе Требования к оборудованию для отказоустойчивого кластера с двумя узлами выше в этом разделе.For more information about the network adapters, see Hardware requirements for a two-node failover cluster, earlier in this guide.

DNS: Для разрешения имен серверы в кластере должны использовать систему доменных имен (DNS).DNS: The servers in the cluster must be using Domain Name System (DNS) for name resolution.

Можно использовать протокол динамического обновления DNS.The DNS dynamic update protocol can be used.

Можно использовать протокол динамического обновления DNS.The DNS dynamic update protocol can be used.Роль домена: Все серверы в кластере должны находиться в одном домене Active Directory.Domain role: All servers in the cluster must be in the same Active Directory domain. Мы рекомендуем, чтобы все кластерные серверы имели одинаковую роль домена (рядовой сервер или контроллер домена).As a best practice, all clustered servers should have the same domain role (either member server or domain controller). Рекомендованная роль — рядовой сервер.The recommended role is member server.

Контроллер домена: Рекомендуется, чтобы кластерные серверы были рядовыми серверами.Domain controller: We recommend that your clustered servers be member servers. Если это так, вам потребуется дополнительный сервер, который выступает в качестве контроллера домена в домене, содержащем отказоустойчивый кластер.If they are, you need an additional server that acts as the domain controller in the domain that contains your failover cluster.

Клиенты: По мере необходимости для тестирования можно подключить один или несколько сетевых клиентов к создаваемому отказоустойчивому кластеру и наблюдать за последствиями на клиенте при перемещении или отработке отказа кластеризованного файлового сервера с одного узла кластера на другой.Clients: As needed for testing, you can connect one or more networked clients to the failover cluster that you create, and observe the effect on a client when you move or fail over the clustered file server from one cluster node to the other.

Учетная запись для администрирования кластера: При первом создании кластера или добавлении в него серверов необходимо войти в домен с учетной записью, обладающей правами администратора и разрешениями на всех серверах в этом кластере.Account for administering the cluster: When you first create a cluster or add servers to it, you must be logged on to the domain with an account that has administrator rights and permissions on all servers in that cluster.

Она не обязательно должна входить в группу «Администраторы домена». Например, это может быть учетная запись пользователя домена, входящая в группу «Администраторы» на каждом кластерном сервере.The account does not need to be a Domain Admins account, but can be a Domain Users account that is in the Administrators group on each clustered server. Кроме того, если учетная запись не является учетной записью администраторов домена, то учетной записи (или группе, в которую входит эта учетная запись) необходимо предоставить разрешения Создание объектов компьютеров и чтение всех свойств в подразделении домена, которое будет размещаться в.In addition, if the account is not a Domain Admins account, the account (or the group that the account is a member of) must be given the Create Computer Objects and Read All Properties permissions in the domain organizational unit (OU) that is will reside in.

Она не обязательно должна входить в группу «Администраторы домена». Например, это может быть учетная запись пользователя домена, входящая в группу «Администраторы» на каждом кластерном сервере.The account does not need to be a Domain Admins account, but can be a Domain Users account that is in the Administrators group on each clustered server. Кроме того, если учетная запись не является учетной записью администраторов домена, то учетной записи (или группе, в которую входит эта учетная запись) необходимо предоставить разрешения Создание объектов компьютеров и чтение всех свойств в подразделении домена, которое будет размещаться в.In addition, if the account is not a Domain Admins account, the account (or the group that the account is a member of) must be given the Create Computer Objects and Read All Properties permissions in the domain organizational unit (OU) that is will reside in.

Действия по установке кластера файловых серверов с двумя узламиSteps for installing a two-node file server cluster

Чтобы установить отказоустойчивый кластер файлового сервера с двумя узлами, необходимо выполнить следующие действия. You must complete the following steps to install a two-node file server failover cluster.

You must complete the following steps to install a two-node file server failover cluster.

Шаг 1. Подключение серверов кластера к сетям и хранилищуStep 1: Connect the cluster servers to the networks and storage

Шаг 2. Установка компонента отказоустойчивого кластераStep 2: Install the failover cluster feature

Шаг 3. Проверка конфигурации кластераStep 3: Validate the cluster configuration

Шаг 4. Создание кластераStep 4: Create the cluster

Если вы уже установили узлы кластера и хотите настроить отказоустойчивый кластер файлового сервера, см. раздел действия по настройке кластера файлового сервера с двумя узлами далее в этом руководстве.If you have already installed the cluster nodes and want to configure a file server failover cluster, see Steps for configuring a two-node file server cluster, later in this guide.

Шаг 1. Подключение серверов кластера к сетям и хранилищуStep 1: Connect the cluster servers to the networks and storage