Пример: копирование ресурсов—Portal for ArcGIS

#!/usr/bin/env python

# Requires Python 2.7+

# Sample Usage:

# python copyContent.py <sourcePortal> <sourceAdmin> <sourcePassword>

# <query> <destinationPortal> <destAdmin>

# <destPassword> <destOwner> <destFolder>

import urllib

import json

import argparse

def generateToken(username, password, portalUrl):

'''Retrieves a token to be used with API requests.'''

parameters = urllib.urlencode({'username' : username,

'password' : password,

'client' : 'referer',

'referer': portalUrl,

'expiration': 60,

'f' : 'json'})

response = urllib.urlopen(portalUrl + '/sharing/rest/generateToken?',

parameters).read()

try:

jsonResponse = json.

loads(response)

if 'token' in jsonResponse:

return jsonResponse['token']

elif 'error' in jsonResponse:

print jsonResponse['error']['message']

for detail in jsonResponse['error']['details']:

print detail

except ValueError, e:

print 'An unspecified error occurred.'

print e

def searchPortal(portal, query=None, totalResults=None, sortField='numviews',

sortOrder='desc', token=None):

'''

Search the portal using the specified query and search parameters.

Optionally provide a token to return results visible to that user.

'''

# Default results are returned by highest

# number of views in descending order.

allResults = []

if not totalResults or totalResults > 100:

numResults = 100

else:

numResults = totalResults

results = __search__(portal, query, numResults, sortField, sortOrder, 0,

token)

if not 'error' in results.

keys():

if not totalResults:

totalResults = results['total'] # Return all of the results.

allResults.extend(results['results'])

while (results['nextStart'] > 0 and

results['nextStart'] < totalResults):

# Do some math to ensure it only

# returns the total results requested.

numResults = min(totalResults - results['nextStart'] + 1, 100)

results = __search__(portal=portal, query=query,

numResults=numResults, sortField=sortField,

sortOrder=sortOrder, token=token,

start=results['nextStart'])

allResults.extend(results['results'])

return allResults

else:

print results['error']['message']

return results

def __search__(portal, query=None, numResults=100, sortField='numviews',

sortOrder='desc', start=0, token=None):

'''Retrieve a single page of search results.

read()

return response

def getItemData(itemId, portalUrl, token):

'''Returns the description for a Portal for ArcGIS item.'''

parameters = urllib.urlencode({'token' : token,

'f' : 'json'})

response = urllib.urlopen(portalUrl + "/sharing/rest/content/items/" +

itemId + "/data?" + parameters).read()

return response

def addItem(username, folder, description, data, portalUrl, token,

thumbnailUrl=''):

'''Creates a new item in a user's content.'''

parameters = urllib.urlencode({'item': json.loads(description)['title'],

'text': data,

'overwrite': 'false',

'thumbnailurl': thumbnailUrl,

'token' : token,

'f' : 'json'})

postParameters = (urllib.urlencode(json.loads(description))

.replace('None', '') + '&' + parameters)

response = urllib.

urlopen(portalUrl + '/sharing/rest/content/users/' +

username + '/' + folder + '/addItem?',

postParameters).read()

return response

def copyItem(itemId, destinationOwner, destinationFolder, sourcePortal,

sourceToken, destinationPortal=None, destinationToken=None):

'''

Copies an item into a user's account in the specified folder.

Use '/' as the destination folder when moving content into root.

'''

# This function defaults to copying into the same Portal

# and with the same token permissions as the source account.

# If the destination is a different Portal then specify that Portal url

# and include a token with permissions on that instance.

if not destinationPortal:

destinationPortal = sourcePortal

if not destinationToken:

destinationToken = sourceToken

description = getItemDescription(itemId, sourcePortal, sourceToken)

data = getItemData(itemId, sourcePortal, sourceToken)

thumbnail = json.

loads(description)['thumbnail']

if thumbnail:

thumbnailUrl = (sourcePortal + '/sharing/rest/content/items/' +

itemId + '/info/' + thumbnail +

'?token=' + sourceToken)

else:

thumbnailUrl = ''

status = addItem(destinationOwner, destinationFolder, description,

data, destinationPortal, destinationToken,

thumbnailUrl)

return json.loads(status)

# Run the script.

if __name__ == '__main__':

parser = argparse.ArgumentParser()

parser.add_argument('sourcePortal',

help=('url of the source Portal (e.g. '

'https://portal.domain.com:7443/arcgis)'))

parser.add_argument('sourceAdmin', help='source admin username')

parser.add_argument('sourcePassword', help='source admin password')

parser.add_argument("query", help='search string to find content')

parser.add_argument('destPortal',

help=('url of the destination Portal (e.

g. '

'https://portal.domain.com:7443/arcgis)'))

parser.add_argument('destAdmin', help='destination admin username')

parser.add_argument('destPassword', help='destination admin password')

parser.add_argument('owner', help='destination account to copy to')

parser.add_argument('folder', help='destination folder to copy to')

# Read the command line arguments.

args = parser.parse_args()

sourcePortal = args.sourcePortal

sourceAdmin = args.sourceAdmin

sourcePassword = args.sourcePassword

query = args.query

destPortal = args.destPortal

destAdmin = args.destAdmin

destPassword = args.destPassword

owner = args.owner

folder = args.folder

# Get a token for the source Portal for ArcGIS.

sourceToken = generateToken(username=sourceAdmin, password=sourcePassword,

portalUrl=sourcePortal)

# Get a token for the destination Portal for ArcGIS.

destToken = generateToken(username=destAdmin, password=destPassword,

portalUrl=destPortal)

# Get the destination folder ID.

'Создание Эффективного Плана Резервного Копирования

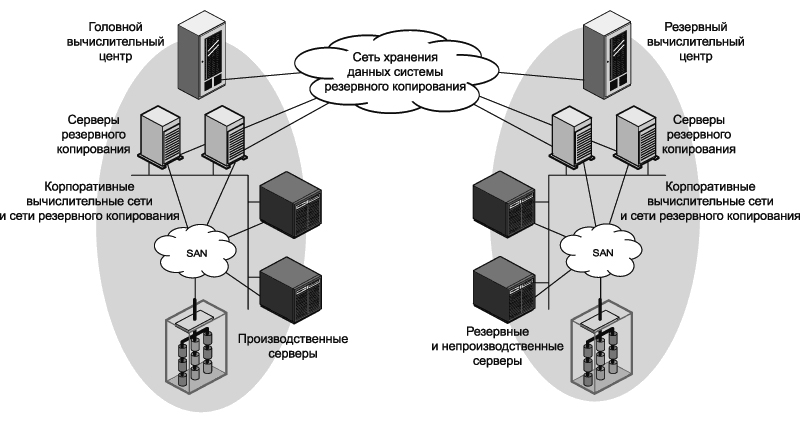

Сегодня как крупные, так и небольшие компании в своей деятельности используют компьютеры и корпоративные серверы. С одной стороны это значительно повышает эффективность повседневной работы, но, с другой стороны, создает все большую зависимость результатов от надежности хранения и доступности электронных данных и используемого для их обработки программного обеспечения. Очень часто неисправность в работе единственного сервера приводит к огромным финансовым затратам. Как правило эффективность работы компании падает до нуля на время восстановления данных и работы системы. Есть много способов снизить риски сбоев в работе аппаратной части компьютера, но наиболее проверенным и надежным способом защиты от утраты данных является регулярное создание резервных копий. Это не понизит риски сбоев в работе компьютера, однако существенно минимизирует причиненный ущерб при неисправности сервера или жесткого диска. При наличии надежного плана резервного копирования восстановление работы неисправного сервера может занять несколько часов а не дней. Это значительно снизит затраты необходимые для восстановления работы, не приведет к длительному простою в работе сотрудников вашей компании и уменьшит расходы на оплату услуг компании по восстановлению данных.

Это значительно снизит затраты необходимые для восстановления работы, не приведет к длительному простою в работе сотрудников вашей компании и уменьшит расходы на оплату услуг компании по восстановлению данных.

Преимущества планового регулярного резервного копирования очевидны, хотя руководители многих компаний все еще сомневаются и не решаются вкладывать в это время и деньги. Раньше владельцы малого бизнеса возможно вполне резонно «шарахались» от стоимости достаточно сложных систем создания резервных копий. План разервного копирования является своего рода страховкой ваших данных (системы и программы обработки которых постоянно совершенствуются), и выплачиваемая вами «страховая премия» обычно несоизмерима с получаемым уровнем защиты. Имея в наличии современное сетевое хранилище данных (устройство NAS) и удобную в использовании профессиональную утилиту резервного копирования (например, R-Drive Image) создание и функционирование надлежащего плана резервного копирования становится достаточно простой и вполне рентабельной задачей. В данной статье это будет показано на примере небольшого корпоративного сервера.

В данной статье это будет показано на примере небольшого корпоративного сервера.

Описанный в этой статье пример демонстрирует возможности R-Drive Image и удобного интерфейса пользователя постороенного по принципу «мастера». Данный план резервного копирования подходит для небольшой корпоративной информационной системы. После его изучения вы сможете без труда воспользоваться приведенной методологией в ваших конкретных условиях.

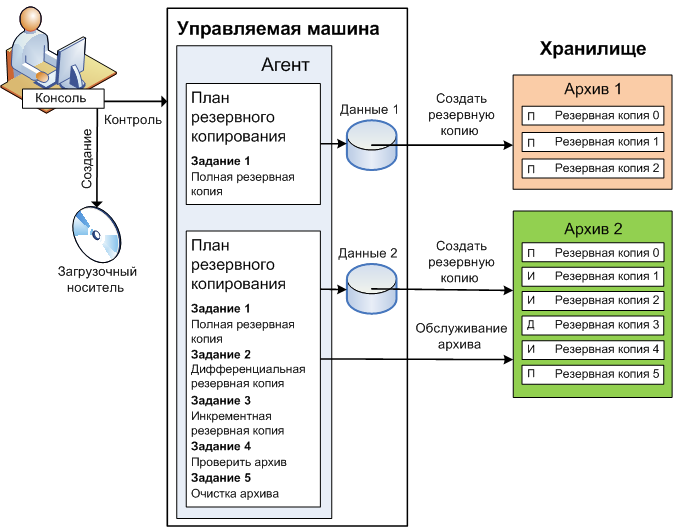

Обзор Плана Резервного Копирования

Прежде чем приступить к созданию самого плана кратко определим конфигурацию копируемой системы и параметры плана резервного копирования.

Структура дисков копируемого сервера

До начала создания плана резервного копирования рассмотрим структуру дисков копируемого сервера или компьютера. Как правило это системный диск и диск с данными. При этом это могут быть два логических диска как на одном физическом, так и на двух разных, также это могут быть и отдельные тома входящие в состав RAID (с т. ч. RAID 0 для системного диска).

ч. RAID 0 для системного диска).

В любом случае необходимо копировать и системный диск и диск с данными. Для обоих дисков лучше всего содать резервную копию тома на дисковом а не на файловом уровне. Резервное копирование путем создания образа всего диска более быстрый процесс, более надежно и позволяет полностью сохранить структуру файлов/папок на томе. Это важно не только для системного диска, где определенные файлы должны находиться в определенных папках, но также и для дисков с данными, так как многие базы данных имеют сложные структуры файлов/папок.

В нашем примере мы будет копировать два логических диска на одном физическом: системный диск (C:) и диск с данными (D:).

План резервного копирования

Зададим чтобы резервная копия создавалась в автономном режиме после окончания рабочего дня и в течение выходных. В этом случае данный процесс не будет пересекаться с основной работой, когда требуется доступ к данным.

План резервного копирования системного диска включает следующее:

- Создавать полный образ первое воскресенье каждого месяца в 14:00.

- Создавать образ в дифференциальном режиме каждое воскресенье в 17:00.

- Резервные копии хранятся в течение трех месяцев.

Данный план позволит произвести «откат» системы на состояние любой недели в течение последних трех месяцев. Например, если критический сбой в работе системы произошел во вторник, то необходимо будет переделать только то что было сделано с момента создания последней резервной копии, т.е. с 17:00 предыдущего воскресенья. Это означает что будут утрачены только около 2 дней работы. Самое большее, что вы можете утратить, это изменения конфигурации системы за последние 7 дней — например, если сбой в работе системы случился в воскресенью до 17:00. Это достаточно приемлемый уровень риска учитывая то что какие-либо изменения системы выполняются не часто.

План резервного копирования диска с данными включает следующее:

- Создавать полный образ первую субботу каждого месяца в 17:00.

- Создавать образ в дифференциальном режиме каждое воскресенье в 17:00.

- Создавать образ в инкрементальном режиме каждый рабочий день в 23:00.

- Резервные копии хранятся в течение трех месяцев.

В соответствии с данным планом состояние данных сохраняется один раз в день, при этом возможно произвести «откат» данных на состояние любого дня в течение последних трех месяцев. Резервная копия создается по субботам а не по воскресеньям и поэтому данное действие не пересекается с копированием системного диска. В этом случае максимум что может быть утрачено это изменения сделанные в течение одного дня — например, если вы сохранили файл во вторник утром и после обеда произошел сбой в работе системы, то можно будет восстановить состояние файлов на вечер понедельника. Если файл был сохранен во вторник вечером до 23:00, а сбой в работе системы произошел на следующее утро, то ничего не будет утрачено.

Режимы Создания Образа: Преимущества и Недостатки

| Полный образ | Файл содержащий полный образ всего диска. Преимущества: Для восстановления всего диска необходим только этот единственный файл. Недостатки: Большой размер. |

| Образ в дифференциальном режиме | Файл содержащий изменения, сделанные на диске от момента создания полного образа до текущего момента. Преимущества: Размер меньше размера полного образа. Недостатки: Размер как правило больше размера инкрементального образа. Для восстановления диска необходим один образ в дифференциальном режиме и полный образ. |

| Образ в инкрементальном режиме | Файл содержащий изменения, сделанные на диске от момента создания последнего образа (полного, дифференциального или инкрементального) до текущего момента. Преимущества: Меньший размер по сравнению с дифференциальным или полным образом.  Недостатки: Для восстановления данных могут потребоваться другие инкрементальные/дифференциальные образы помимо полного образа. Если какой-либо из инкрементальных образов поврежден, то не удастся также восстановить и данные из более поздних инкрементальных копий. |

Место хранения резервных копий

Наиболее безопасным местом для хранения резервных копий будет удаленный сервер, физически расположенный где-то в другом месте. Это убережет сервер с резервными копиями и ваши данные от, например, пожара или каких-либо других форс-мажорных обстоятельств, которые могут случиться в вашем здании. Другой вариант это хранить резервные копии на каком-либо другом оборудовании в том же здании. Это защитит вас от утраты данных при сбое в работе аппаратной части (т.к. если резервные копии находятся на используемом в работе физическом диске, то при сбое могут быть утрачены как сами данные, так и их резервные копии).

Рис.1. Рекомендуемая схема сети при резервном копировании небольшого корпоративного сервера

Кликните по изображению для его увеличения

В качестве удаленного сервера не обязательно использовать какое-либо дорогостоящее оборудование. Здесь вполне может подойти экономичное и надежное сетевое хранилище данных (устройство NAS). Его возможно приобрести практически в любом магазине торгующем компьютерами и IT оборудованием.

Обратите внимание, что многие устройства NAS выпускаются с поддержкой внутренних томов RAID. Для хранения резервных копий используйте отказоустойчивые уровни RAID — например, RAID 1, RAID 4, RAID 5 или RAID 6. Не используйте чередующиеся тома (RAID 0) — если один из его дисков выйдет из строя, то все данные будут утрачены.

R-Drive Image совместим с любой серверной платформой поддерживающей сетевой протокол SMB. Среди них Windows, MAC OS и Linux. В большинстве устройствах NAS используются разновидности ОС Linux.

В нашем примере мы будем хранить резервную копию на удаленном сервере в сети (BCK-UBUNTU).

Email уведомления

После завершения создания резервной копии отправляется сообщение электронной почты о результатах операции. Его пример можно посмотреть в разделе Примеры E-mail Уведомления в конце данной статьи.

Копирование Системного Диска

Ежемесячный полный образ системного диска

Первая часть в плане резервного копирования системного диска это ежемесячный полный образ создаваемый в первое воскресенье каждого месяца в 14:00.

1. На этапе Выбор Действия (Action Selection) нажмите Планировщик задач / Создать Скрипт (Scheduler / Create a Script).

Рис. 2. Ежемесячный полный образ системного диска — этап Выбор Действия (Action Selection)

Кликните по изображению для его увеличения

2. На этапе Расписание выполнения Задач (Scheduled Tasks) нажмите кнопку Создать задачу (Create a task).

Рис. 3. Ежемесячный полный образ системного диска — этап Расписание выполнения Задач (Scheduled Tasks)

Кликните по изображению для его увеличения

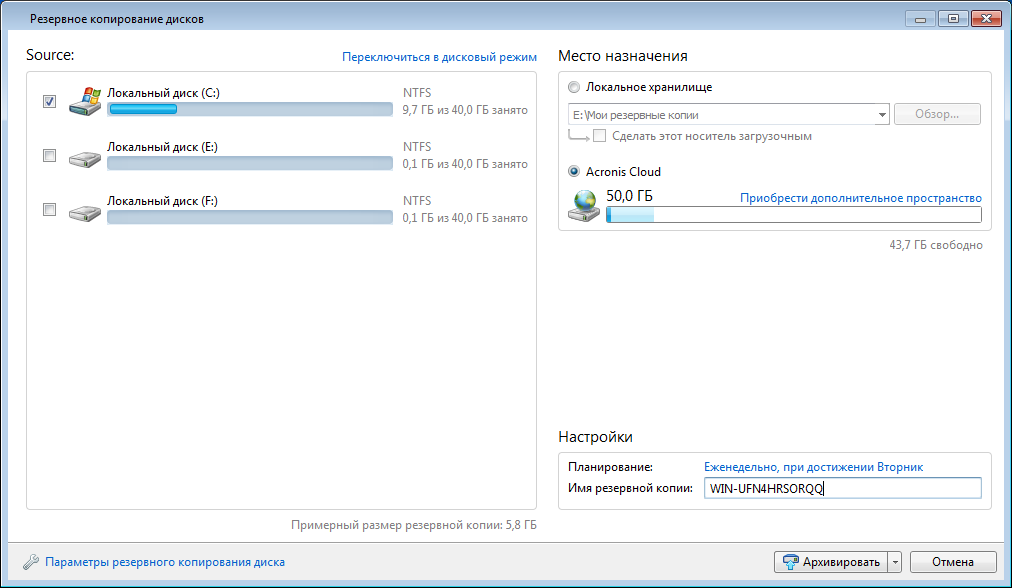

3. На этапе Выбор Раздела (Partition Selection) выберите системный раздел резервную копию которого вы будете создавать. В нашем примере системный раздел это C:.

Рис. 4. Ежемесячный полный образ системного диска — этап Выбор Раздела (Partition Selection)

Кликните по изображению для его увеличения

При создании резервной копии системного диска Windows 7 и более поздней версии Windows не забудьте также выбрать небольшой активный раздел на котором находится загрузчик системы. В более ранних версиях Windows такого раздела нет.

4. На этапе Месторасположение Образа (Image Destination) выберите месторасположение файла образа и имя файла.

В нашем примере мы выберем находящийся в сети сервер для резервных копий BCK-UBUNTU и папку Backups. Может потребоваться ввести имя пользователя и пароль для получения доступа к папке сетевого диска.

Может потребоваться ввести имя пользователя и пароль для получения доступа к папке сетевого диска.

Рис. 5. Ежемесячный полный образ системного диска — этап Месторасположение Образа (Image Destination)

Кликните по изображению для его увеличения

5. Задайте параметры резервных комплектов на этапе Режим Создания Образа (Imaging Mode) как показано на нижеприведенном рисунке.

Рис. 6. Ежемесячный полный образ системного диска — этап Режим Создания Образа (Imaging Mode)

Кликните по изображению для его увеличения

Введите 3 в поле Максимальное число резервных комплектов (Maximum number of backup sets) и установите радиокнопку Создать новый полный образ (Create a new full image). Более подробную информацию об остальных параметрах можно найти в R-Drive Image online Справке — раздел Резервные Комплекты (Backup Sets).

6. Задайте необходимые параметры на этапе Параметры Образа (Image Options) как показано на нижеприведенном рисунке.

Рис. 7. Ежемесячный полный образ системного диска — этап Параметры Образа (Image Options)

Кликните по изображению для его увеличения

Более подробную информацию об остальных параметрах можно найти в R-Drive Image online Справке — раздел Создание Образа (Create an Image).

7. Задайте необходимые параметры на этапе Параметры Резервного Копирования (Backup Options) как показано на нижеприведенном рисунке.

Рис. 8. Ежемесячный полный образ системного диска — этап Параметры Резервного Копирования (Backup Options)

Кликните по изображению для его увеличения

Более подробную информацию об остальных параметрах можно найти в R-Drive Image online Справке — раздел: Создание Образа (Create an Image).

8. Задайте необходимые параметры на этапе Время/Событие (Time/Event) как показано на нижеприведенном рисунке.

Рис. 9. Ежемесячный полный образ системного диска — этап Время/Событие (Time/Event)

Кликните по изображению для его увеличения

9. Задайте необходимые параметры на этапе Пользователь/Пароль (User/Password).

Задайте необходимые параметры на этапе Пользователь/Пароль (User/Password).

Рис. 10. Ежемесячный полный образ системного диска — этап Пользователь/Пароль (User/Password)

Кликните по изображению для его увеличения

10. Задайте параметры E-mail уведомления на этапе E-mail Уведомления/Внешние Утилиты (Mail Notification/AUX Applications) как показано на нижеприведенном рисунке.

Рис. 11. Ежемесячный полный образ системного диска — этап E-mail Уведомления/Внешние Утилиты (Mail Notification/AUX Applications)

Кликните по изображению для его увеличения

На этом же этапе можно проверить настройки e-mail нажав кнопку Проверка E-mail… (Test mail account…). R-Drive Image отправит тестовое e-mail сообщение на указанный в настройках адрес.

11. Подтвердите корректность параметров задачи на этапе Обработка (Processing) и нажмите кнопку Сохранить (Save).

Рис. 12. Ежемесячный полный образ системного диска — этап Обработка (Processing)

12. Ежемесячный полный образ системного диска — этап Обработка (Processing)

Кликните по изображению для его увеличения

Чтобы изменить какой-либо параметр задачи нажмите кнопку Назад (Back) и вернитесь на соответствующий этап.

Если вы нажмете кнопку Сохранить (Save), то созданная задача появится в списке на этапе Расписание выполнения Задач (Scheduled Tasks).

Рис. 13. Ежемесячный полный образ системного диска — этап Расписание выполнения Задач (Scheduled Tasks)

Кликните по изображению для его увеличения

Еженедельный образ системного диска в дифференциальном режиме

Следующий этап это создание еженедельного образа в дифференциальном режиме. В состав резервной копии войдут только измененные или добавленные данные с момента последнего создания полного образа. Размеры файлов образов в этом случае будут меньше и на их создание потребуется меньше времени, что является более удобным при выполнении еженедельных операций резервного копирования.

1. Нажмите кнопку Создать задачу (Create a task) на этапе Расписание выполнения Задач (Scheduled Tasks), выберите системный раздел на этапе Выбор Раздела (Partition Selection) и выберите на этапе Месторасположение Образа (Image Destination) тот же самый файл образ что и при создании полного образа.

2. Задайте параметры резервных комплектов на этапе Режим Создания Образа (Imaging Mode).

Рис. 14. Еженедельный образ системного диска в дифференциальном режиме — этап Режим Создания Образа (Imaging Mode)

Кликните по изображению для его увеличения

Введите 3 в поле Максимальное число резервных комплектов (Maximum number of backup sets) и установите радиокнопку Добавлять изменения дифференциально к последнему образу в резервном комплекте (Append changes differentially to the last image in the backup set).

Если созданный полный образ диска был защищен паролем, то вам потребуется его ввести.

3. Задайте необходимые параметры на этапах Параметры Образа (Image Options) и Параметры Резервного Копирования (Backup Options) также как и при создании полного образа.

4. Задайте необходимые параметры на этапе Время/Событие (Time/Event).

Рис. 15. Еженедельный образ системного диска в дифференциальном режиме — этап Время/Событие (Time/Event)

Кликните по изображению для его увеличения

Проверьте чтобы Время начала (Start time) не совпадало со временем создания полного образа. В нашем примере ежемесячный полный образ создается в 14:00 и еженедельный образ в дифференциальном режиме в 17:00.

5. Задайте необходимые параметры на этапе Пользователь/Пароль (User/Password).

6. Задайте необходимые параметры на этапе E-mail Уведомления/Внешние Утилиты (Mail Notifications/AUX Applications) также как и при создании полного образа.

Рис. 16. Еженедельный образ системного диска в дифференциальном режиме — этап E-mail Уведомления/Внешние Утилиты (Mail Notifications/AUX Applications)

Кликните по изображению для его увеличения

Измените Тему уведомления: (Custom subject:) на Server1:

differential system disk backup.

7. Подтвердите корректность параметров задачи на этапе Обработка (Processing)

и нажмите кнопку Сохранить (Save).

Рис. 17. Еженедельный образ системного диска в дифференциальном режиме — этап Обработка (Processing)

Кликните по изображению для его увеличения

Созданная задача появится в списке на этапе Расписание выполнения Задач (Scheduled Tasks).

Рис. 18. Еженедельный образ системного диска в дифференциальном режиме — этап Расписание выполнения Задач (Scheduled Tasks)

Кликните по изображению для его увеличения

Копирование Диска с Данными

Ежемесячный полный образ диска с данными

Данный процесс во многом схож с копированием системного диска за исключением того, что в этом случае создается образ раздела с данными (D:).

1. На этапе Расписание выполнения Задач (Scheduled Tasks) нажмите кнопку Создать задачу (Create a task).

2. Выберите раздел с данными (D:) на этапе Выбор Раздела (Partition Selection).

Рис. 19. Ежемесячный полный образ диска с данными — этап Выбор Раздела (Partition Selection)

Кликните по изображению для его увеличения

3. На этапе Месторасположение Образа (Image Destination) выберите месторасположение файла образа и имя файла.

Рис. 20. Ежемесячный полный образ диска с данными — этап Месторасположение Образа (Image Destination)

Кликните по изображению для его увеличения

4. Задайте параметры резервных комплектов на этапе Режим Создания Образа (Imaging Mode).

Рис. 21. Ежемесячный полный образ диска с данными — этап Режим Создания Образа (Imaging Mode)

Кликните по изображению для его увеличения

Установите 3 в поле Максимальное число резервных комплектов (Maximum number of backup sets) и установите радиокнопку Создать новый полный образ (Create a new full image).

5. Задайте необходимые параметры на этапах Параметры Образа (Image Options) и Параметры Резервного Копирования (Backup Options) также как и при создании полного образа системного диска.

6. Задайте необходимые параметры на этапе Время/Событие (Time/Event).

Рис. 22. Ежемесячный полный образ диска с данными — этап Время/Событие (Time/Event)

Кликните по изображению для его увеличения

7. Задайте необходимые параметры на этапе Пользователь/Пароль (User/Password).

8. Задайте параметры E-mail уведомления на этапе E-mail Уведомления/Внешние Утилиты (Mail

Notification/AUX Applications).

Рис. 23. Ежемесячный полный образ диска с данными — этап E-mail Уведомления/Внешние Утилиты (Mail

Notification/AUX Applications)

Кликните по изображению для его увеличения

9. Подтвердите корректность параметров задачи на этапе Обработка (Processing) и нажмите кнопку Сохранить (Save).

Рис. 24. Ежемесячный полный образ диска с данными — этап Обработка (Processing)

Кликните по изображению для его увеличения

Созданная задача появится в списке на этапе Расписание выполнения Задач (Scheduled Tasks).

Рис. 25. Ежемесячный полный образ диска с данными — этап Расписание выполнения Задач (Scheduled Tasks)

Кликните по изображению для его увеличения

Еженедельный образ диска с данными в дифференциальном режиме

Данный процесс также во многом схож с созданием образа системного диска в дифференциальном режиме за исключением того, что в этом случае создается образ раздела с данными (D:).

1. На этапе Расписание выполнения Задач (Scheduled Tasks) нажмите кнопку Создать задачу (Create a task), выберите раздел с данными (т.е. D:) на этапе Выбор Раздела (Partition Selection) и выберите месторасположение файла образа и имя файла (то же файл образ что и при создании полного образа диска с данными) на этапе Месторасположение Образа (Image Destination).

2. Задайте параметры резервных комплектов на этапе Режим Создания Образа (Imaging Mode).

Рис. 26. Еженедельный образ диска с данными в дифференциальном режиме — этап Режим Создания Образа (Imaging Mode)

Кликните по изображению для его увеличения

Введите 3 в поле Максимальное число резервных комплектов (Maximum number of backup sets) и установите радиокнопку Добавлять изменения дифференциально к последнему образу в резервном комплекте (Append changes differentially to the last image in the backup set).

3. Задайте необходимые параметры на этапах Параметры Образа (Image Options) и Параметры Резервного Копирования также как и при создании полного образа диска с данными.

4. Задайте необходимые параметры на этапе Время/Событие (Time/Event).

Рис. 27. Еженедельный образ диска с данными в дифференциальном режиме — этап Время/Событие (Time/Event)

Кликните по изображению для его увеличения

5. Задайте необходимые параметры на этапе Пользователь/Пароль (User/Password).

Задайте необходимые параметры на этапе Пользователь/Пароль (User/Password).

6. Задайте параметры E-mail уведомления на этапе E-mail Уведомления/Внешние Утилиты (Mail

Notification/AUX Applications).

Рис. 28. Еженедельный образ диска с данными в дифференциальном режиме — этап E-mail Уведомления/Внешние Утилиты (Mail

Notification/AUX Applications)

Кликните по изображению для его увеличения

7. Подтвердите корректность параметров задачи на этапе Обработка (Processing) и нажмите кнопку Сохранить (Save).

Рис. 29. Еженедельный образ диска с данными в дифференциальном режиме — этап Обработка (Processing)

Кликните по изображению для его увеличения

Созданная задача появится в списке на этапе Расписание выполнения Задач (Scheduled Tasks).

Рис. 30. Еженедельный образ диска с данными в дифференциальном режиме — этап Расписание выполнения Задач (Scheduled Tasks)

Кликните по изображению для его увеличения

Ежедневный образ диска с данными в инкрементальном режиме

Образ в инкрементальном режиме содержит измененные или добавленные данные с момента последнего любого резервного копирования (полного, дифференциального или инкрементального). Размеры файлов образов в этом случае будут меньше размеров файлов образов созданных в дифференциальном режиме, что является более удобным при выполнении ежедневных операций резервного копирования.

Размеры файлов образов в этом случае будут меньше размеров файлов образов созданных в дифференциальном режиме, что является более удобным при выполнении ежедневных операций резервного копирования.

1. Нажмите кнопку Создать задачу (Create a task) на этапе Расписание выполнения Задач (Scheduled Tasks), выберите раздел с данными на этапе Выбор Раздела (Partition Selection) и выберите на этапе Месторасположение Образа (Image Destination) тот же самый файл образ что и при создании полного образа диска с данными.

2. Задайте параметры резервных комплектов на этапе Режим Создания Образа (Imaging Mode).

Рис. 31. Ежедневный образ диска с данными в инкрементальном режиме — этап Режим Создания Образа (Imaging Mode)

Кликните по изображению для его увеличения

Введите 3 в поле Максимальное число резервных комплектов (Maximum number of backup sets) и установите радиокнопку Добавлять изменения инкрементально к последнему образу в резервном комплекта (Append changes incrementally to the

last image in the backup set).

3. Задайте необходимые параметры на этапах Параметры Образа (Image Options) и Параметры Резервного Копирования (Backup Options) также как и при создании полного образа диска с данными.

4. Задайте необходимые параметры на этапе Время/Событие (Time/Event).

Рис. 32. Ежедневный образ диска с данными в инкрементальном режиме — этап Время/Событие (Time/Event)

Кликните по изображению для его увеличения

5. Задайте необходимые параметры на этапе Пользователь/Пароль (User/Password).

6. Задайте параметры E-mail уведомления на этапе E-mail Уведомления/Внешние Утилиты (Mail

Notification/AUX Applications)

Рис. 33. Ежедневный образ диска с данными в инкрементальном режиме — этап E-mail Уведомления/Внешние Утилиты (Mail

Notification/AUX Applications)

Кликните по изображению для его увеличения

7. Подтвердите корректность параметров задачи на этапе Обработка (Processing)

и нажмите кнопку Сохранить (Save).

Рис. 34. Ежедневный образ диска с данными в инкрементальном режиме — этап Обработка (Processing)

Кликните по изображению для его увеличения

Созданная задача появится в списке на этапе Расписание выполнения Задач (Scheduled Tasks).

Рис. 35. Ежедневный образ диска с данными в инкрементальном режиме — этап Расписание выполнения Задач (Scheduled Tasks)

Кликните по изображению для его увеличения

Структура Файлов Плана Резервного Копирования

Теперь план резервного копирования готов. Вы начнете получать уведомления о завершении операций резервного копирования. Описание уведомления (примеры) вы найдете далее в этой статье.

Созданные R-Drive Image файлы образы будут иметь следующие имена:

- Полный образ: <имя_файла>_<дата_первого_образа>_<время_первого_образа>_1.rdr

- Образы в инкрементальных и дифференциальных режимах: <имя_файла>_<дата_первого_образа>_<время_первого_образа>_N+1.

rdr

rdr

где N это число ранее созданных инкрементальных или дифференциальных образов.

В описанном выше примере R-Drive Image создаст следующие файлы:

Образ системного диска

| Дата/День недели/Время |

Файлы Новые создаваемые файлы выделены жирным |

Тип образа |

Номер Резервного Комплекта |

| Начало Резервного Комплекта 1 |

|||

| 2013-09-01 /Воскресенье /

14:00 2013-09-01 /Воскресенье / 17:00 |

SystemDisk_20130901_020000PM_1. rdr rdrSystemDisk_20130901_020000PM_2.rdr |

Полный образ Дифф. образ |

Резервный Комплект 1 |

| 2013-09-08 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.rdr |

Полный образ Дифф. образ Дифф. образ |

|

| 2013-09-15 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.  rdr rdrSystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ |

|

| 2013-09-22 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ |

|

| 2013-09-29 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1. rdr rdrSystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ |

|

| Начало Резервного Комплекта 2 |

|||

| 2013-10-06 /Воскресенье /

14:00 2013-10-06 /Воскресенье / 17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.  rdr rdrSystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ |

Резервные Комплекты 1,2 |

| 2013-10-13 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.  rdr rdrSystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ |

|

| 2013-10-20 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.  rdr rdrSystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr SystemDisk_20131006_020000PM_4.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ |

|

| 2013-10-27 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1. rdr rdrSystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr SystemDisk_20131006_020000PM_4.rdr SystemDisk_20131006_020000PM_5.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ |

|

| Начало Резервного Комплекта 3 |

|||

| 2013-11-03 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1. rdr rdrSystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr SystemDisk_20131006_020000PM_4.rdr SystemDisk_20131006_020000PM_5.rdr SystemDisk_20131103_020000PM_1.rdr SystemDisk_20131103_020000PM_2.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф.  образ образДифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ |

Резервные Комплекты 1,2,3 |

| 2013-11-10 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr SystemDisk_20131006_020000PM_4.  rdr rdrSystemDisk_20131006_020000PM_5.rdr SystemDisk_20131103_020000PM_1.rdr SystemDisk_20131103_020000PM_2.rdr SystemDisk_20131103_020000PM_3.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ |

|

| 2013-11-17 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.  rdr rdrSystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr SystemDisk_20131006_020000PM_4.rdr SystemDisk_20131006_020000PM_5.rdr SystemDisk_20131103_020000PM_1.rdr SystemDisk_20131103_020000PM_2.rdr SystemDisk_20131103_020000PM_3.rdr SystemDisk_20131103_020000PM_4.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф.  образ образПолный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ |

|

| 2013-11-24 /Воскресенье /

17:00 |

SystemDisk_20130901_020000PM_1.rdr SystemDisk_20130901_020000PM_2.rdr SystemDisk_20130901_020000PM_3.rdr SystemDisk_20130901_020000PM_4.rdr SystemDisk_20130901_020000PM_5.rdr SystemDisk_20130901_020000PM_6.rdr SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.  rdr rdrSystemDisk_20131006_020000PM_4.rdr SystemDisk_20131006_020000PM_5.rdr SystemDisk_20131103_020000PM_1.rdr SystemDisk_20131103_020000PM_2.rdr SystemDisk_20131103_020000PM_3.rdr SystemDisk_20131103_020000PM_4.rdr SystemDisk_20131103_020000PM_5.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ |

|

Начало Резервного Комплекта 4. Резервный Комплект 1 удален. Резервный Комплект 1 удален. |

|||

| 2013-12-01 /Воскресенье /

17:00 |

SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr SystemDisk_20131006_020000PM_4.rdr SystemDisk_20131006_020000PM_5.rdr SystemDisk_20131103_020000PM_1.rdr SystemDisk_20131103_020000PM_2.rdr SystemDisk_20131103_020000PM_3.rdr SystemDisk_20131103_020000PM_4.rdr SystemDisk_20131103_020000PM_5.rdr SystemDisk_20131201_020000PM_1.rdr SystemDisk_20131201_020000PM_2.rdr |

Полный образ Дифф. образ Дифф.  образ образДифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ |

Резервные Комплекты 2,3,4 |

| 2013-12-08 /Воскресенье /

17:00 |

SystemDisk_20131006_020000PM_1.rdr SystemDisk_20131006_020000PM_2.rdr SystemDisk_20131006_020000PM_3.rdr SystemDisk_20131006_020000PM_4.rdr SystemDisk_20131006_020000PM_5.rdr SystemDisk_20131103_020000PM_1.rdr SystemDisk_20131103_020000PM_2.rdr SystemDisk_20131103_020000PM_3.  rdr rdrSystemDisk_20131103_020000PM_4.rdr SystemDisk_20131103_020000PM_5.rdr SystemDisk_20131201_020000PM_1.rdr SystemDisk_20131201_020000PM_2.rdr SystemDisk_20131201_020000PM_3.rdr |

Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ Дифф. образ Дифф. образ Полный образ Дифф. образ Дифф. образ |

|

Образ диска с данными

Ниже приведен пример структуры файлов одного из резервных комплектов. Показано начало Резервного Комплекта 2.

| Дата/День недели/Время |

Файл |

Тип образа |

| 2013-08-31 /Суббота

/5:00 2013-08-31 /Суббота /15:00 |

DataDisk_20130831_050000AM_1. rdr rdrDataDisk_20130831_050000PM_2.rdr |

Полный Дифф. |

| 2013-09-02 /Понедельник

/23:00 |

DataDisk_20130831_050000AM_3.rdr |

Инкр. |

| 2013-09-03 /Вторник

/23:00 |

DataDisk_20130831_050000AM_4.rdr |

Инкр. |

| 2013-09-04 /Среда

/23:00 |

DataDisk_20130831_050000AM_5.rdr |

Инкр. |

| 2013-09-05 /Четверг

/23:00 |

DataDisk_20130831_050000AM_6. rdr rdr |

Инкр. |

| 2013-09-06 /Пятница

/23:00 |

DataDisk_20130831_050000AM_7.rdr |

Инкр. |

| 2013-09-07 /Суббота

/3:00PM |

DataDisk_20130831_050000AM_8.rdr |

Дифф. |

| 2013-09-09 /Понедельник

/23:00 |

DataDisk_20130831_050000AM_9.rdr | Инкр. |

| 2013-09-10 /Вторник /

23:00 |

DataDisk_20130831_050000AM_10. rdr rdr |

Инкр. |

| 2013-09-11 /Среда

/23:00 |

DataDisk_20130831_050000AM_11.rdr |

Инкр. |

| 2013-09-12 /Четверг

/23:00 |

DataDisk_20130831_050000AM_12.rdr |

Инкр. |

| 2013-09-13 /Пятница

/23:00 |

DataDisk_20130831_050000AM_13.rdr | Инкр. |

| 2013-09-14 /Суббота

/15:00 |

DataDisk_20130831_050000AM_14. rdr rdr |

Дифф. |

| 2013-09-16 /Понедельник

/23:00 |

DataDisk_20130831_050000AM_15.rdr |

Инкр. |

| 2013-09-17 /Вторник

/23:00 |

DataDisk_20130831_050000AM_16.rdr |

Инкр. |

| 2013-09-18 /Среда

/23:00 |

DataDisk_20130831_050000AM_17.rdr |

Инкр. |

| 2013-09-19 /Четверг

/23:00 |

DataDisk_20130831_050000AM_18. rdr rdr |

Инкр. |

| 2013-09-20 /Пятница

/23:00 |

DataDisk_20130831_050000AM_19.rdr

|

Инкр. |

| 2013-09-21 /Суббота

/15:00 |

DataDisk_20130831_050000AM_20.rdr |

Дифф. |

| 2013-09-23 /Понедельник

/23:00 |

DataDisk_20130831_050000AM_21.rdr |

Инкр. |

| 2013-09-24 /Вторник

/23:00 |

DataDisk_20130831_050000AM_22. rdr rdr |

Инкр. |

| 2013-09-25 /Среда

/23:00 |

DataDisk_20130831_050000AM_23.rdr |

Инкр. |

| 2013-09-26 /Четверг

/23:00 |

DataDisk_20130831_050000AM_24.rdr |

Инкр. |

| 2013-09-27 /Пятница

/23:00 |

DataDisk_20130831_050000AM_25.rdr |

Инкр. |

| 2013-09-28 /Суббота

/15:00 |

DataDisk_20130831_050000AM_26. rdr rdr |

Дифф. |

| 2013-09-30 /Понедельник

/23:00 |

DataDisk_20130831_050000AM_27.rdr |

Инкр. |

| 2013-10-01 /Вторник

/23:00 |

DataDisk_20130831_050000AM_28.rdr |

Инкр. |

| 2013-10-02 /Среда

/23:00 |

DataDisk_20130831_050000AM_29.rdr |

Инкр. |

| 2013-10-03 /Четверг

/23:00 |

DataDisk_20130831_050000AM_30. rdr rdr |

Инкр. |

| 2013-10-04 /Пятница

/23:00 |

DataDisk_20130831_050000AM_31.rdr |

Инкр. |

| Начало Резервного Комплекта 2 |

||

| 2013-10-05 /Суббота

/5:00 2013-10-05 /Суббота /15:00 |

DataDisk_20131005_050000AM_1.rdr DataDisk_20131005_050000AM_2.rdr |

Полный Дифф. |

Вы можете удалять ежедневные инкрементальные образы созданные в период времени между созданием полных и дифференциальных образов не теряя при этом целестности данных. Например, после создания файла DataDisk_20130831_050000AM_8.rdr можно удалить файлы начиная с DataDisk_20130831_050000AM_3.rdr и заканчивая DataDisk_20130831_050000AM_7.rdr.

Например, после создания файла DataDisk_20130831_050000AM_8.rdr можно удалить файлы начиная с DataDisk_20130831_050000AM_3.rdr и заканчивая DataDisk_20130831_050000AM_7.rdr.

Протоколирование

Можно сохранить файл журнала операций R-Drive Image. Для этого нажмите кнопку О программе (About) на этапе Выбор Действия (Action Selection), установите флажок Протоколирование (Logging) и задайте имя и путь к файлу.

Рис. 36. R-Drive Image: Протоколирование

Кликните по изображению для его увеличения

Примеры E-mail Уведомления

После завершения операции резервного копирования R-Drive Image будет отправлять E-mail уведомление.

При Успешном завершении операции уведомление будет иметь следующий вид:

R-Drive Image 5.1 (Build 5100)Command: create /a /o -s=»hdd_size=640135028736+part_num=1+hdd_num=1+hdd_target_id=0+hdd_bus_type=sata2

+part_ofs=1048576+hdd_name=SAMSUNG HD642JJ1AA01110+part_size=367001600+hdd_port_num=2

+hdd_serial=S1AFJ1MQ400283+part_fs=ntfs+hdd_vtype=real,hdd_size=640135028736+part_num=2

+hdd_num=1+hdd_target_id=0+hdd_bus_type=sata2+part_label=System+part_ofs=368050176

+part_mounted=C:\+hdd_name=SAMSUNG HD642JJ1AA01110+part_size=209348198400

+hdd_port_num=2+hdd_serial=S1AFJ1MQ400283+part_fs=ntfs+hdd_vtype=real»

-a=»\\BCK-UBUNTU\Net_Drive\Backups\SystemDisk.

rdr» -p=»******» -r=»Full backup image of the system disk.»

rdr» -p=»******» -r=»Full backup image of the system disk.»-c=»6″ -u -check -bs -bs-num-b=»3″ -ms=»mail.example.com:25″ -ml=»******» -ma=»[email protected]»

-mr=»[email protected]» -mc=»Server 1: full system disk backup» -mx -me

Start at: Sun, 01 Sep 2013 14:00:00 -0500

Finish at: Sun, 01 Sep 2013 15:08:39 -0500

Success

Operations:

Create an Image: \\BCK-UBUNTU\Net_Drive\Backups\SystemDisk.rdr

Backup partition [SAMSUNG HD642JJ1AA01110 (596GB #1)]

Active Partition #1 (NTFS 350MB)

C: System (NTFS 194GB #2)

Backup disk partition structure

SAMSUNG HD642JJ1AA01110 (596GB #1)

Check an Image File

Execution log:

* Create an Image: \\BCK-UBUNTU\Net_Drive\Backups\SystemDisk.rdr

Backup partition [SAMSUNG HD642JJ1AA01110 (596GB #1)]

Active Partition #1 (NTFS 350MB)

C: System (NTFS 194GB #2)

Backup disk partition structure

SAMSUNG HD642JJ1AA01110 (596GB #1)

Check an Image File

* Operation completed successfully

Если операция завершилась неудачно, то уведомление будет выглядеть так:

R-Drive Image 5. 1 (Build 5100)

1 (Build 5100)Command: create /a /o -s=»hdd_size=522713088+part_num=1+hdd_num=2+hdd_target_id=0

+hdd_bus_type=usb+part_label=RS+part_ofs=65536+hdd_name=Flash Disk4.00

+part_size=522647552+hdd_port_num=0+hdd_serial=078163578514+part_fs=fat16+hdd_vtype=real»

-a=»D:\Backups\HDD2_2-image.rdr» -u -check -ms=»smtp.example.com:25″

-ml=»******» -ma=»[email protected]» -mr=»[email protected]»

-mc=» Flash backup» -mx -me

Start at: Sun, 01 Sep 2013 18:06:47 -0500

Finish at: Sun, 01 Sep 2013 18:06:49 -0500

ERROR: Internal error (error #0:3831)

Operations:

Create an Image: D:\Backups\HDD2_2-image.rdr

Backup partition [KingstonDataTraveler 400PMAP (3.74GB #2)]

Active Partition #1 NEW VOLUME (FAT32 3.73GB)

Backup disk partition structure

KingstonDataTraveler 400PMAP (3.74GB #2)

Check an Image File

Execution log:

! KingstonDataTraveler 400PMAP: Partition at 32 extends beyond disk bounds

! KingstonDataTraveler 400PMAP: Partition at 32 extends beyond disk bounds

* Create an Image: D:\Backups\HDD2_2-image. rdr

rdr

Backup partition [KingstonDataTraveler 400PMAP (3.74GB #2)]

Active Partition #1 NEW VOLUME (FAT32 3.73GB)

Backup disk partition structure

KingstonDataTraveler 400PMAP (3.74GB #2)

Check an Image File

! Read disk KingstonDataTraveler 400PMAP at position 16896 failed after 2 attempts. The handle is invalid (6)

! Read disk KingstonDataTraveler 400PMAP at position 16896 failed after 2 attempts. The handle is invalid (6)

! Read disk at position 2671616 failed after 2 attempts. The handle is invalid (6)

! Operation failed: Internal error (error #0:3831)

Заключение

Создать план резервного копирования при помощи R-Drive Image можно достаточно быстро, эффективно и экономично. Имея R-Drive Image, устройство NAS и план резервного копирования можно оградить себя ото всех неудобств и значительных финансовых затрат имеющих место при утрате данных. В данном статье было показано насколько просто можно создать план резервного копирования. Для получения более подробной информации обо всех имеющихся параметрах резервного копирования и составления своего плана обратитесь к R-Drive Image online справке.

Для получения более подробной информации обо всех имеющихся параметрах резервного копирования и составления своего плана обратитесь к R-Drive Image online справке.

Цены AWS Backup | Централизованное резервное копирование в облаке | Amazon Web Services

Суммарное использование (гигабайт‑часы) = [400 ГБ х 15 дней х (24 часа в день)] + [800 ГБ х 15 дней х (24 часа в день)] = 432 000 ГБ‑часов

Для вычисления месячной платы ГБ‑часы суммируются и конвертируются в ГБ‑месяцы.

Общая стоимость использования хранилища за месяц = 600 ГБ‑месяцев х 0,05 USD = 30 USD

Допустим, что вы выполнили 10 резервных копий размером по 40 ГБ, каждая из региона Восток США (Сев. Вирджиния) в регион Запад США (Сев. Калифорния). К концу месяца объем переданных между регионами данных в гигабайтах будет рассчитываться следующим образом.

Суммарное использование = 10 передач данных между регионами x 40 ГБ = 400 ГБ

Суммарная стоимость передачи данных между регионами = 400 ГБ x 0,04 USD = 16 USD

Далее было выполнено восстановление данных из 10 резервных копий объемом 1 ГБ каждая. Объем восстановленных к концу месяца данных в гигабайтах будет рассчитываться следующим образом.

Суммарный объем = восстановление из 10 копий x 1 ГБ = 10 ГБ

Общая стоимость восстановления за месяц = 10 ГБ x 0,02 USD =0,20 USD

Далее, допустим, было выполнено восстановление 10 файлов объемом 100 МБ каждый за две отдельных транзакции. К концу месяца объем восстановленных на уровне объектов данных в гигабайтах будет рассчитываться следующим образом.

Суммарный объем = восстановление из 10 копий x 100 МБ = 1 ГБ

Суммарный объем запросов на уровне объектов = 2 запроса (5 объектов в каждом)

Суммарная месячная плата за восстановление на уровне данных = (1 ГБ x 0,02 USD) + (2 запроса x 0,60 USD) = 0,02 USD + 1,20 USD = 1,22 USD

Наконец, предположим, что вы выполняете 1500 оценок резервного копирования в двух регионах AWS в течение месяца. А эти оценки затрагивают записи 2000 элементов конфигурации (по одному элементу конфигурации для каждой оценки и 500 дополнительных элементов из-за изменения базовых ресурсов резервного копирования). Объем использования AWS Backup Audit Manager к концу месяца будет рассчитываться следующим образом.

Общее количество оценок резервного копирования: 1500 оценок x 2 региона = 3000 оценок резервного копирования

Стоимость оценок резервного копирования: 3000 оценок x (1,25 USD / 1000) = 3,75 USD*

Стоимость элементов конфигурации в AWS Config: 2000 x 0,003 USD = 6,00 USD**

Общая плата за AWS Backup Audit Manager в месяц = 9,75 USD

Итоговый счет за использование AWS Backup в течение месяца складывается из стоимости использования хранилища резервных копий, стоимости копирования и восстановления.

Итоговый счет за использование AWS Backup в течение месяца = 30 USD + 16 USD + 0,20 USD + 1,22 USD + 9,75 USD = 57,17 USD

*Оплата за эту часть будет начислена в AWS Backup

**Оплата за эту часть будет начислена в AWS Config

Пример резервного копирования базы Oracle средствами операционной системы ( NOARCHIVELOG)

Никому не рекомендуется так делать!

Нужно поднять базу из скопированных файлов на каком-нибудь другом сервере

Глупость это все — копировать файлы по отдельности. Если база не в ASM, просто копируются все файлы на другой сервер и меняются некоторые параметры в конфигах. Если с ASM, то RMAN.

SQL> archive log list;

Database log mode No Archive Mode

Automatic archival Disabled

Archive destination USE_DB_RECOVERY_FILE_DEST

Oldest online log sequence 7

Current log sequence 9

Если нет, можно перевести в режим NOARCHIVELOG следующими командами.

SQL> shutdown immediate;

SQL> startup mount;

SQL> alter database noarchivelog;

SQL> alter database open;

$ mkdir -p /tmp/backups/ORCL12/{DATAFILE,CONTROLFILE,PARAMETERFILE}

SQL> CREATE PFILE = '/tmp/backups/ORCL12/PARAMETERFILE/pfile.txt' from SPFILE;

SQL> ALTER DATABASE BACKUP CONTROLFILE TO TRACE as '/tmp/backups/ORCL12/CONTROLFILE/controlfile.txt';

RMAN> report schema;

using target database control file instead of recovery catalog

Report of database schema for database with db_unique_name ORCL12

List of Permanent Datafiles

===========================

File Size(MB) Tablespace RB segs Datafile Name

---- -------- -------------------- ------- ------------------------

1 790 SYSTEM YES +DATA/ORCL12/DATAFILE/system.258.888429421

3 650 SYSAUX NO +DATA/ORCL12/DATAFILE/sysaux.257. 888429347

4 135 UNDOTBS1 YES +DATA/ORCL12/DATAFILE/undotbs1.260.888429497

6 5 USERS NO +DATA/ORCL12/DATAFILE/users.259.888429497

List of Temporary Files

=======================

File Size(MB) Tablespace Maxsize(MB) Tempfile Name

---- -------- -------------------- ----------- --------------------

1 197 TEMP 32767 +DATA/ORCL12/TEMPFILE/temp.265.888429595

888429347

4 135 UNDOTBS1 YES +DATA/ORCL12/DATAFILE/undotbs1.260.888429497

6 5 USERS NO +DATA/ORCL12/DATAFILE/users.259.888429497

List of Temporary Files

=======================

File Size(MB) Tablespace Maxsize(MB) Tempfile Name

---- -------- -------------------- ----------- --------------------

1 197 TEMP 32767 +DATA/ORCL12/TEMPFILE/temp.265.888429595

Создание консистентного бекапа.

RMAN> shutdown immediate;

$ export ORACLE_HOME=$GRID_HOME

$ export ORACLE_SID=+ASM

$ asmcmd ls +DATA/ORCL12/DATAFILE

SYSAUX.257.888429347

SYSTEM.258.888429421

UNDOTBS1.260.888429497

USERS.259.888429497

$ asmcmd ls +DATA/ORCL12/CONTROLFILE/

Current.261.888429547

$ asmcmd ls +DATA/ORCL12/PARAMETERFILE

spfile.266.888429941

$ asmcmd cp +DATA/ORCL12/DATAFILE/SYSAUX. 257.888429347 /tmp/backups/ORCL12/DATAFILE

$ asmcmd cp +DATA/ORCL12/DATAFILE/SYSTEM.258.888429421 /tmp/backups/ORCL12/DATAFILE

$ asmcmd cp +DATA/ORCL12/DATAFILE/UNDOTBS1.260.888429497 /tmp/backups/ORCL12/DATAFILE

$ asmcmd cp +DATA/ORCL12/DATAFILE/USERS.259.888429497 /tmp/backups/ORCL12/DATAFILE

257.888429347 /tmp/backups/ORCL12/DATAFILE

$ asmcmd cp +DATA/ORCL12/DATAFILE/SYSTEM.258.888429421 /tmp/backups/ORCL12/DATAFILE

$ asmcmd cp +DATA/ORCL12/DATAFILE/UNDOTBS1.260.888429497 /tmp/backups/ORCL12/DATAFILE

$ asmcmd cp +DATA/ORCL12/DATAFILE/USERS.259.888429497 /tmp/backups/ORCL12/DATAFILE

$ asmcmd cp +DATA/ORCL12/CONTROLFILE/Current.261.888429547 /tmp/backups/ORCL12/CONTROLFILE

$ asmcmd cp +DATA/ORCL12/PARAMETERFILE/spfile.266.888429941 /tmp/backups/ORCL12/PARAMETERFILE

$ cd /tmp/backups/

$ tar -cvzpf ORCL12.tar.gz ./ORCL12

Восстановление из бекапа

Восстанавливаю на другом сервере с тем же инстансом:

$ cd /tmp/backups/

$ tar -xvzpf ORCL12.tar.gz ./

Купирую теперь уже на ASM.

$ export ORACLE_HOME=$GRID_HOME

$ export ORACLE_SID=+ASM

$ asmcmd mkdir +DATA/ORCL12

$ asmcmd mkdir +DATA/ORCL12/DATAFILE

$ asmcmd mkdir +DATA/ORCL12/CONTROLFILE

$ asmcmd mkdir +DATA/ORCL12/PARAMETERFILE

$ asmcmd mkdir +DATA/ORCL12/ARCHIVELOG

$ asmcmd mkdir +ARCH/ORCL12/ARCHIVELOG

Команда cp не может скопировать на ASM файлы без цифр. Приходится копировать без них. Из-за этого потом придется еще и пересоздавать контролфайл.

Приходится копировать без них. Из-за этого потом придется еще и пересоздавать контролфайл.

$ asmcmd cp /tmp/backups/ORCL12/DATAFILE/SYSAUX.257.888429347 +DATA/ORCL12/DATAFILE/SYSAUX

$ asmcmd cp /tmp/backups/ORCL12/DATAFILE/SYSTEM.258.888429421 +DATA/ORCL12/DATAFILE/SYSTEM

$ asmcmd cp /tmp/backups/ORCL12/DATAFILE/UNDOTBS1.260.888429497 +DATA/ORCL12/DATAFILE/UNDOTBS1

$ asmcmd cp /tmp/backups/ORCL12/DATAFILE/USERS.259.888429497 +DATA/ORCL12/DATAFILE/USERS

Каталог, который должен быть обязательно создан

$ mkdir -p /u01/oracle/admin/ORCL12/adump

$ cd /tmp/backups/ORCL12/PARAMETERFILE/

$ cp pfile.txt pfile.txt.bkp

Удалил строки касающиеся контролфайла:

*.control_files='+DATA/ORCL12/CONTROLFILE/current.261.888429547','+ARCH/ORCL12/CONTROLFILE/current.256.888429547'

Получилось:

ORCL12.__data_transfer_cache_size=0

ORCL12.__db_cache_size=822083584

ORCL12. __java_pool_size=16777216

ORCL12.__large_pool_size=33554432

ORCL12.__oracle_base='/u01/oracle'#ORACLE_BASE set from environment

ORCL12.__pga_aggregate_target=402653184

ORCL12.__sga_target=1207959552

ORCL12.__shared_io_pool_size=50331648

ORCL12.__shared_pool_size=268435456

ORCL12.__streams_pool_size=0

*.audit_file_dest='/u01/oracle/admin/ORCL12/adump'

*.audit_trail='db'

*.compatible='12.1.0.2.0'

*.db_block_size=8192

*.db_create_file_dest='+DATA'

*.db_domain=''

*.db_name='ORCL12'

*.db_recovery_file_dest='+ARCH'

*.db_recovery_file_dest_size=4560m

*.diagnostic_dest='/u01/oracle'

*.dispatchers='(PROTOCOL=TCP) (SERVICE=ORCL12XDB)'

*.open_cursors=300

*.pga_aggregate_target=382m

*.processes=300

*.remote_login_passwordfile='EXCLUSIVE'

*.sga_target=1148m

*.undo_tablespace='UNDOTBS1'

__java_pool_size=16777216

ORCL12.__large_pool_size=33554432

ORCL12.__oracle_base='/u01/oracle'#ORACLE_BASE set from environment

ORCL12.__pga_aggregate_target=402653184

ORCL12.__sga_target=1207959552

ORCL12.__shared_io_pool_size=50331648

ORCL12.__shared_pool_size=268435456

ORCL12.__streams_pool_size=0

*.audit_file_dest='/u01/oracle/admin/ORCL12/adump'

*.audit_trail='db'

*.compatible='12.1.0.2.0'

*.db_block_size=8192

*.db_create_file_dest='+DATA'

*.db_domain=''

*.db_name='ORCL12'

*.db_recovery_file_dest='+ARCH'

*.db_recovery_file_dest_size=4560m

*.diagnostic_dest='/u01/oracle'

*.dispatchers='(PROTOCOL=TCP) (SERVICE=ORCL12XDB)'

*.open_cursors=300

*.pga_aggregate_target=382m

*.processes=300

*.remote_login_passwordfile='EXCLUSIVE'

*.sga_target=1148m

*.undo_tablespace='UNDOTBS1'

$ export ORACLE_HOME=/u01/oracle/database/12.1

$ export ORACLE_SID=ORCL12

SQL> startup nomount pfile=/tmp/backups/ORCL12/PARAMETERFILE/pfile.txt

SQL> create spfile from memory;

SQL> shutdown immediate;

$ cd /tmp/backups/ORCL12/CONTROLFILE

$ cp controlfile. txt controlfile.txt.bkp

$ vi controlfile.txt

txt controlfile.txt.bkp

$ vi controlfile.txt

Взял часть кода “RESETLOGS case”. Пришлось удалить цифры в названии файлов данных. Выполняю по частям в консоли:

SQL> CREATE CONTROLFILE REUSE DATABASE "ORCL12" RESETLOGS NOARCHIVELOG

MAXLOGFILES 16

MAXLOGMEMBERS 3

MAXDATAFILES 100

MAXINSTANCES 8

MAXLOGHISTORY 292

LOGFILE

GROUP 1 (

'+DATA/ORCL12/ONLINELOG/group_1.262.888429551',

'+ARCH/ORCL12/ONLINELOG/group_1.257.888429559'

) SIZE 50M BLOCKSIZE 512,

GROUP 2 (

'+DATA/ORCL12/ONLINELOG/group_2.263.888429563',

'+ARCH/ORCL12/ONLINELOG/group_2.258.888429569'

) SIZE 50M BLOCKSIZE 512,

GROUP 3 (

'+DATA/ORCL12/ONLINELOG/group_3.264.888429575',

'+ARCH/ORCL12/ONLINELOG/group_3.259.888429581'

) SIZE 50M BLOCKSIZE 512

-- STANDBY LOGFILE

DATAFILE

'+DATA/ORCL12/DATAFILE/system',

'+DATA/ORCL12/DATAFILE/sysaux',

'+DATA/ORCL12/DATAFILE/undotbs1',

'+DATA/ORCL12/DATAFILE/users'

CHARACTER SET AL32UTF8

;

SQL> select status from v$instance;

STATUS

------------

MOUNTED

SQL> SELECT MEMBER FROM V$LOG G, V$LOGFILE F WHERE G. GROUP# = F.GROUP# AND G.STATUS = 'CURRENT';

MEMBER

--------------------------------------------------------------------------------

+ARCH/ORCL12/ONLINELOG/group_3.259.888429581

+DATA/ORCL12/ONLINELOG/group_3.264.888429575

GROUP# = F.GROUP# AND G.STATUS = 'CURRENT';

MEMBER

--------------------------------------------------------------------------------

+ARCH/ORCL12/ONLINELOG/group_3.259.888429581

+DATA/ORCL12/ONLINELOG/group_3.264.888429575

SQL> RECOVER DATABASE USING BACKUP CONTROLFILE UNTIL CANCEL

ORA-00279: change 1678308 generated at 08/22/2015 18:18:48 needed for thread 1

ORA-00289: suggestion : +ARCH

ORA-00280: change 1678308 for thread 1 is in sequence #9

Specify log: {<RET>=suggested | filename | AUTO | CANCEL}

ORA-00308: cannot open archived log '+ARCH'

ORA-17503: ksfdopn:2 Failed to open file +ARCH

ORA-15045: ASM file name '+ARCH' is not in reference form

На каком-то сайте написано, что можно игнорировать такого рода ошибки. Данная база никогда не работала в режиме Archivelog. Впрочем база открылась.

SQL> ALTER DATABASE OPEN RESETLOGS;

Database altered.

SQL> ALTER TABLESPACE TEMP ADD TEMPFILE '+DATA/ORCL12/TEMPFILE/temp' SIZE 206569472 REUSE AUTOEXTEND ON NEXT 655360 MAXSIZE 32767M;

SQL> create spfile from memory;

После всех шагов, нужно сделать бекап

Копирование файлов с помощью rsync.

Rsync — Примеры синхронизации

Rsync — Примеры синхронизацииУ замечательной и очень популярной программы rsync есть множество удобных опций и необычайных способностей, вот только их не так-то просто найти. Ну, если только вы не готовы прочитать весь мануал от корки до корки.

Попробую сберечь вам немного времени на чтение мануала и рассказать о самом важном и полезном. Простыми словами, как есть.

Зачем нужен rsync?

Зачем пользоваться rsync если есть привычные cp и scp , спросите вы.

В одной части rsync удобней и лучше упомянутых аналогов потому что он дает вам возможность увидеть все что он сделает при копировании файлов до непосредственно операции копирования.

В другой части — rsync по умолчанию копирует только новые и изменившиеся файлы, и даже не только файлы — а отдельные их части, делая это жестоко и эффективно.

Только этих двух причин достаточно чтобы в своей ежедневной работе забыть про cp , променяв эту команду и ее аналоги на rsync .

Принцип применения

Если мы говорим о простом копировании файлов, то первым делом всегда стоит сделать пробный прогон (ключ -n) в режиме с показом подробностей (-v):

rsync -avn source example. com:destination

com:destination

В этом режиме rsync покажет список файлов, которые он скопирует. Будут скопированы только новые и изменившиеся файлы. Вы сможете убедиться что копируется сам каталог, а не содержимое, или что копируется именно содержимое.

После того как вы убедились что копируется именно то, что вы хотите, можно запускать самое настоящее копирование:

rsync -av source example.com:destination

В этой команде ключ -a подразумевает рекурсивное копирование всех файлов и каталогов включая их атрибуты, такие как дата создания и дата изменения. Ключ -v даст вам подробный отчет о работе по мере выполнения и по окончании.

Правила копирования каталогов

С одной стороны правила очень простые.

Если в конце пути до именованного источника нет слеша, то скопируется сам каталог.

$ rsync -avn path/to/source example.com:destination sending incremental file list source/ source/example.html …

Если слеш есть, или источник указывает на каталог без имени, то скопируется содержимое каталога. sending incremental file list

example.html

…

# Что эквивалентно такой команде:

$ cd path/to/source; rsync -avn . example.com:destination

sending incremental file list

example.html

…

# Что эквивалентно такой команде:

$ cd path/to/source; rsync -avn . example.com:destination

С другой стороны вполне можно в пылу забыть что и как, скопировав содержимое каталога вместо самого каталога , получив кучу хлопот с удалением лишних файлов, появившихся из ниоткуда с датами в прошлом (ключик -a , помните?).

Потому лучше всегда следовать обычному сценарию с предварительной проверкой операции.

Некоторые полезные ключи

Сначала поговорим об опциях которые вам будет здорово знать без шпор и шпаргалок.

Ключ -P включает сразу несколько опций. С этим ключем rsync и покажет процесс копирования отдельных файлов, и продолжит копирование если оно было прервано. Особо эта опция пригождается при копировании больших файлов. Ключ -P нужно указывать каждый раз, иначе rsync удалит файлы которые не успели полностью закачаться.

Если вы копируете файлы с какого-то очень занятого, или слабого, сервера, то можно исключить трату ресурсов процессора на вычисление изменившихся частей файлов, скопировав их целиком. Для этого нужен ключ -W .

Для этого нужен ключ -W .

Если вам хочется знать сколько всего, по мнению rsync, осталось работать, вам нужен ключ —info=progress2 . Если вы копируете целую файловую систему, то этот ключ, будучи использован сам по себе, вас разочарует: информация об итоговом объёме будет постоянно обновляться. Это происходит потому что rsync не пытается считать всю файловую систему до того как начнёт копирование, а делает обе задачи сразу.

Но не отчаивайтесь! Если вы хотите знать точно сколько осталось работать с самого начала, то можно отключить последовательное сканирование ключём —no-inc-recursive или, короче, —no-i-r .

$ rsync -ah —partial —info=progress2 —no-i-r source example.com:destination 623.38M 0% 82.23MB/s 0:11:10

Ключи выше есть начиная с версии 3.1.0, то есть уже работают в Debian stable.

Если требуется не просто скопировать файлы, а полностью синхронизировать содержимое каталогов, удалив лишние файлы, при этом вам почему-то не с руки синхронизировать файлы с помощью Git , то пригодится ключ —delete (или эквивалентный ему —del).

С этим ключём rsync удалит лишние файлы из каталого-назначения.

$ rsync -avn —delete source example.com:destination sending incremental file list deleting source/bad.txt source/ source/test.txt

Ключ -n в команде выше был оставлен намеренно.

О сжатии замолвим слово

Вопреки популярному заблуждению от использования сжатия внутри rsync (ключ -z) больше вреда, чем пользы. Дело в том что всюду используемый OpenSSH уже с версии конца 2005 года по-умолчанию использует сжатие передаваемых данных. Сами понимаете, сжатие уже сжатых данных только лишь использует ресурсы процессора, не уменьшая объем передаваемых данных.

В том, что при соединении с вашим сервером уже используется сжатие, можно убедиться так:

$ ssh -v [email protected] false 2>&1 | grep compression debug1: Enabling compression at level 6.

Если эта команда не покажет , в числе прочих, такую строчку про включение сжатия как выше, то может быть вам стоит использовать сжатие. Стоит проверить что от сжатия есть толк. Особенно это касается маломощных устройств с быстрым соединением: вашему NAS может быть быстрее скопировать что-то по гигабитному линку без сжатия, чем пытаться обогнать гигабитную сеть маломощным процессором.

Стоит проверить что от сжатия есть толк. Особенно это касается маломощных устройств с быстрым соединением: вашему NAS может быть быстрее скопировать что-то по гигабитному линку без сжатия, чем пытаться обогнать гигабитную сеть маломощным процессором.

К счастью, rsync достаточно умен чтобы не использовать сжатие если вы копируете файлы локально, из каталога на диск и т.п.

Копируем частично

Наверняка вам когда-нибудь понадобится чтобы rsync пропускал некоторые файлы при копировании.

В самом простейшем случае вам нужно чтобы rsync не копировал файлы разных систем контроля версий, включая каталог вроде.svn и.git . В этой задаче вам не нужно ничего кроме ключа -C (или —cvs-exclude в полной форме). Так файлы большинства популярных VCS будут проигнорированы будто их нет. Не забываем использовать -n при первом запуске.

rsync -nC example.com:source destination

Может получиться так что вы, по ошибке, скопируете кучу таких файлов от VCS. В этом случае для получения чистой копии вам пригодится ключ —delete-excluded , с которым все исключенные файлы будут удалены.

rsync -nC —delete-excluded example.com:source destination

Исключаем через.rsync-filter

Если нужные более гибкие правила, что особенно актуально если копирование делается регулярно, то лучше не мелочиться и оформить все исключения в файле.rsync-filter .

$ cat source/.rsync-filter — test.bin — *.tmp — /.cache — /example/ — /**/Trash/ — /.mozilla/firefox/*/Cache/ + Projects/**/Trash/

Для исключения чего-либо из списка на перенос нужно добавить в этот файл строчку с правилом (- или + в начале строки).

Если нужно исключить конкретный файл, где бы он ни был в любом каталоге ниже по иерархии, то укажем просто имя файла.

# никакой файл test.bin не будет скопирован — test.bin # все файлы.tmp будут пропущены — *.tmp

Если нужно исключить файл или каталог относительно каталога в котором находится.rsync-filter , то укажем со слешем в начале:

# не будет скопирован каталог или файл.cache, но будут скопированы foo/.cache и foo/bar/. cache

— /.cache

# не будет скопирован каталог example, но будет скопирован файл example

— /example/

cache

— /.cache

# не будет скопирован каталог example, но будет скопирован файл example

— /example/

В правилах звездочка соответствует любым символам кроме слеша, а две звездочки соответствуют вообще любым символам:

# будут пропущены каталоги.local/share/Trash/ и Documents/example/Trash/ — /**/Trash/ # не будет пропущен каталог.mozilla/firefox/abcd.profile/ext/Cache/ # но будет пропущен каталог.mozilla/firefox/abcd.profile/Cache/ — /.mozilla/firefox/*/Cache/

Наконец, если нужно чтобы какие-то файлы всё-таки копировались, не смотря на ранее заданные правила, то их можно отметить правилом + в начале строки.

# каталог Projects/Example/layout/Trash/ будет скопирован + Projects/**/Trash/

Файлы.rsync-filter команда rsync умеет искать по всей структуре каталогов будучи запущена с ключём -F .

Если нужно чтобы сами эти файлы не копировались, то нужно указать этот ключ два раза так:

$ rsync -avFFn source example.com:destination

sending incremental file list

source/

source/example. html

source/tmp/

source/tmp/foo.bin

sent 174 bytes received 30 bytes 408.00 bytes/sec

total size is 18,400 speedup is 90.20 (DRY RUN)

html

source/tmp/

source/tmp/foo.bin

sent 174 bytes received 30 bytes 408.00 bytes/sec

total size is 18,400 speedup is 90.20 (DRY RUN)

Как видите, лишние файлы не скопировались:

$ ls source/.rsync-filter source/foo.tmp source/foo.tmp source/.rsync-filter $ cat source/.rsync-filter — *.tmp

Ограничим rsync по ssh

Случается нужно разрешить работу rsync по ssh, удалённо и без пароля, только определённого для каталога и хоста, исключив копирование чего-либо в другие места или из других мест.

Например, вы хотите чтобы можно было скопировать файлы на сервер backup.example.com только с хоста server.example.com , только и только в каталог backup-example , и только с этими опциями:

$ rsync -aW —del source/ backup.example.com:destination/backup-example/

То сначала нужно получить команду, которую rsync выполняет при вызове ssh на удаленном хосте:

$ rsync -e «ssh -t -v» -aW —del source/ backup.example.com:destination/backup-example/ 2>&1 | grep command

debug1: Sending command: rsync —server -lWogDtpre. iLsfxC —delete-during . destination/backup-example/

iLsfxC —delete-during . destination/backup-example/

Соответственно, в ~/.ssh/authorized_keys на example.com следует добавить для известного ssh ключа запуск этой команды по-умолчанию при подключении:

from=»server.example.com»,command=»rsync —server -lWogDtpre.iLsfxC —delete-during . destination/backup-example/»,no-pty,no-port-forwarding ssh-rsa AAAA… # дальше ваш ключ

Таким образом, даже если при запуске rsync будут указаны какие-то другие опции, на сервере-назначении всё равно выполнится команда rsync соответствующая исходным, заданным вами, опциям и настройкам.

Если нужно чтобы ваш бекап нельзя было перезаписать или удалить на сервере назначения, то опцию —del следует заменить на —ignore-existing .

Машина времени

Те пользователи macOS и OS X, что делают бэкап, наверняка оценили работу Time Machine . Эта программа позволяет буквально в два клика вернуться к прошлой версии любого файла. Не смотря на все красивости, Time Machine не делает ничего такого чего мы не можем сделать с помощью rsync .

#!/bin/bash set -o nounset -o errexit cd $(dirname » $0 » ) date = $(date —iso-8601 = seconds) test -L latest || ln -s » $date » latest rsync —delete-excluded —prune-empty-dirs —archive -F —link-dest = ../latest » [email protected] » «./ $date » rm latest ln -s » $date » latest

Скрипт следует положить в корень того диска или каталога, куда следует делать бэкапы.

Запускать с указанием единственного аргумента: каталога с исходными файлами. Например, так.

/mnt/backups/backup /home

После нескольких запусков получается такая структура каталога:

2017-02-08T22:05:04+09:00 2017-02-08T22:10:05+09:00 2017-02-08T22:15:05+09:00 2017-02-08T22:20:06+09:00 2017-02-08T22:25:05+09:00 2017-02-08T22:30:04+09:00 latest -> 2017-02-08T22:30:04+09:00

При этом latest указывает на самый последний бэкап.

В каждом из каталогов содержится слепок того, что было в исходном каталоге в момент копирования. Можно подумать что и место на диске занято пропорционально количеству копий, однако это не так.

$ du -sh /mnt/backups 4,5M /mnt/backups $ du -sh /home 3,8M /home

Всё множество копий занимает лишь немного больше места чем исходный каталог. Место уходит на изменившиеся файлы.

Если ничего не менялось, то место всё равно расходуется на создание каталогов, которые нельзя хранить как жесткие ссылки .

$ du -hs 2017-02-08T22:20:06+09:00 2017-02-08T22:25:05+09:00 2017-02-08T22:30:04+09:00 3,8M 2017-02-08T22:20:06+09:00 136K 2017-02-08T22:25:05+09:00 136K 2017-02-08T22:30:04+09:00

Такая существенная экономия возможна благодаря упомянутым жестким ссылкам, которые rsync делает для файлов, не изменившихся с последнего копирования.

$ stat -c «%i» 2017-02-08*/example.txt | uniq 31819810

У одинаковых, не менявшихся, файлов будет один и тот же inode.

Конечно, по возможной экономии места на диске такому способу резервного копирования далеко до специальных программам, таких как

rsync в основном предназначен для удаленной синхронизации.

rsync используется для выполнения операций резервного копирования в UNIX / Linux.

rsync — это утилита, которая используется для синхронизации файлов и директорий двух различных локаций. Считается как одна из самых эффективных. Резервные копии можно создавать как на локальном сервере так и на удаленном.

Некоторые важные возможности rsync

Скорость : В первый раз, rsync реплицирует полностью весь контент между источниками и каталогами назначения. В дальнейшем, rsync перемещает только измененные блоки или байты в назначенную локацию, причем делает это действительно быстро. Также имеется возможность ограничить скорость синхронизации.

Безопасность : rsync позволяет шифровать информацию, используя ssh протокол в процессе перемещения данных.

Меньшая пропускная способность : rsync использует блочное сжатие и распаковку данных на приемной и отправляющей стороне в указанном порядке, возможность «докачки» файлов. Таким образом пропускная способность будет использоваться rsync-ом всегда гораздо меньше по сравнению с остальными протоколами передачи данных.

Если имеется доступ по ssh к серверу, это наиболее простой способ для осуществления синхронизации.

Rsync по ssh — это частный случай использования, общий вид команды выглядит так:

Rsync [ОПЦИИ] [ПОЛЬЗОВАТЕЛЬ@]СЕРВЕР:ИСТОЧНИК… [ПОЛУЧАТЕЛЬ] Pull (копирование файлов с удаленной системы на локальную) rsync [ОПЦИИ] ИСТОЧНИК 1 [ИСТОЧНИК N] [ПОЛЬЗОВАТЕЛЬ@]СЕРВЕР:ПОЛУЧАТЕЛЬ

Push (копирование файлов с локальной машины на удаленную)

Обязательным параметром является «ИСТОЧНИК», их может быть несколько.

Рассмотрим несколько примеров:

Примеры:

Скопируется на сервер 192.168.1.1 содержимое папок /backup/file1/ /backup/file2/ в папку backup

В этом примере уже скопируются сами папки

# rsync -zavP /backup/file1/ /backup/file2/ [email protected]:/backup

Как ограничить скорость передачи файлов? Нужно поставить опцию —bwlimit:

# rsync -zavP —bwlimit=100 /backup/file1/ [email protected]:/backup

Как синхронизировать файлы с проверкой по контрольной сумме?

# rsync -сzavP /backup/file1/ [email protected]:/backup

Как скопировать файлы с удаленной машины на локальную?

# rsync -zavP [email protected]:/backup /backup/file1/

Как исключить файл или директорию при копировании?

Исключаем директорию temp файл test. txt и все файлы с расширением tgz расположенные в /home/data

txt и все файлы с расширением tgz расположенные в /home/data

# rsync -azVP —exclude temp/ —exclude test.txt —exclude *.tgz /home/data/ [email protected]:/backup

Как удалить файлы на приемнике, если их не существует на источнике?